重要

このページの日本語コンテンツは古くなっている可能性があります。最新の英語版コンテンツをご覧になるには、こちらをクリックしてください。

監査ログへのアクセスと消費¶

Confluent Cloud の監査ログは、スタンダードクラスターと専用クラスターではデフォルトで有効になっています。ベーシッククラスターには監査ログが含まれません。

ライブの監査ログレコードは 7 日後に削除されますが、監査ログを別の Kafka クラスターまたは外部のシステムに複製することで保持することができます。詳細については、「監査ログレコードの保持」を参照してください。

前提条件¶

- Kafka クライアント

- クライアントが SASL 認証をサポートしていれば、任意の Kafka クライアント <https://docs.confluent.io/platform/current/clients/index.html>`__(|confluent-cli|、`C/C++、Java など)を使用して、Confluent Cloud の監査ログトピックのデータを消費できます。このため、前提条件は使用する Kafka クライアントによって異なります。Confluent Cloud クライアントの構成の詳細については、「Confluent Cloud クライアントの構成」を参照してください。

- 消費の構成

- Confluent Cloud Console には、任意の Kafka クライアントにコピーアンドペーストできる構成が用意されています。この構成を使用して、監査ログクラスターに接続し、監査ログトピックから消費することができます。

- クラスターのタイプ

スタンダードクラスター と 専用クラスター は監査ログをサポートし、これらはデフォルトで有効になっています。ベーシッククラスター には監査ログが含まれません。

注釈

ベーシッククラスターをスタンダードクラスターにアップグレードする場合は、アップグレードしたクラスターで監査ログを有効にするにあたって、Confluent サポートにお問い合わせください。

監査ログのユーザーインターフェイスへのアクセス¶

Confluent Cloud Console で監査ログ情報にアクセスするには Administration メニューをクリックします。自分のロールに組織を管理する権限があり、スタンダード クラスターまたは 専用 クラスターが少なくとも 1 つ組織に存在する場合、Audit log をクリックして監査ログのクラスター情報にアクセスします。有効化は自動的に行われます。通常、スタンダードクラスターまたは専用クラスターの初回プロビジョニングが正常に実行されてから 5 分以内に有効になります。

Confluent CLI を使用した消費¶

Confluent Cloud 監査ログへのアクセスには、OrganizationAdmin が必要です。

ターミナルを開き、Confluent Cloud 組織にログインします。

confluent login

confluent audit-log describeコマンドを実行して、使用するリソースを確認します。次の例は、サンプルクラスターに提供されている監査ログ情報を示しています。

confluent audit-log describe +-----------------+----------------------------+ | Cluster | lkc-yokxv6 | | Environment | env-x11xz | | Service Account | sa-ymnkzp | | Topic Name | confluent-audit-log-events | +-----------------+----------------------------+

confluent environment useコマンドとconfluent kafka cluster useコマンドを実行して、使用する環境とクラスターを指定します。環境名とクラスター名は、前の手順で取得したデータで確認できます。confluent environment use env-x11xz confluent kafka cluster use lkc-yokxv6

監査ログクラスターの API キーとシークレットが既にある場合は、

confluent api-key storeコマンドを使用してローカルに保存できます。confluent api-key store <API-key> --resource lkc-yokxv6

監査ログクラスターの既存の API キーを表示するには、

confluent api-key listコマンドに--resourceオプションを付けて実行します。confluent api-key list --resource lkc-yokxv6

注釈

監査ログトピックからデータを消費するには、API キーとシークレットが必要です。

監査ログクラスターに使用する API キーとシークレットを新たに作成する必要がある場合は、次の

confluent api-createコマンドに--service-accountオプションと--resourceオプションを付けて実行します。confluent api-key create --service-account sa-ymnkzp --resource lkc-yokxv6

注釈

必ず、API キーとシークレットを保存してください。このシークレットを後から取得することは "できません"。

重要

監査ログクラスターの API キーは、事前定義されたサービスアカウントを使用して作成する必要があります。監査ログクラスターの識別子を取得するには、Confluent CLI の

confluent audit-log describeコマンドを実行します。API キーは、監査ログクラスター 1 つにつき 2 つに制限されています。監査ログクラスターの既存の API キーを削除する必要がある場合は、次のコマンドを実行します。

confluent api-key delete <API-key>

API キーとシークレットの作成後、次のコマンドに API キーをコピーアンドペーストします。

confluent api-key use <API-key> --resource lkc-yokxv6

監査ログトピックから監査ログイベントを消費します。

confluent kafka topic consume -b confluent-audit-log-events

このコマンドで使用できるオプションの詳細については、「confluent kafka topic consume」を参照してください。

削除した API キーを使用して新しい接続を確立することはできません。キーのローテーションを行うには、新しいキーを作成し、その新しいキーを使用するようにクライアントを構成した後、古いキーを削除してください。

認証に使用されているイベントを "ライブ" で観察するとともに、どの Kafka クラスター API キーが使用されているかを確認するには、次のようにします。

confluent kafka topic consume confluent-audit-log-events > audit-events.json &

tail -f audit-events.json \

| grep 'kafka.Authentication' \

| jq .data.authenticationInfo.metadata.identifier \

> recently-used-api-keys.txt &

tail -f recently-used-api-keys.txt

注釈

jq コマンドライン JSON プロセッサーはサードパーティのソフトウェアであり、Confluent Cloud には付属しておらずインストールもされていません。使用する場合は、別途ダウンロードしてインストールする必要があります。

Java を使用した消費¶

Confluent Cloud 監査ログへのアクセスには、OrganizationAdmin が必要です。

https://confluent.cloud で Confluent Cloud Console にサインインします。

Confluent Cloud Console の右上の Administration メニューから、ADMINISTRATION、Audit log の順に移動します。

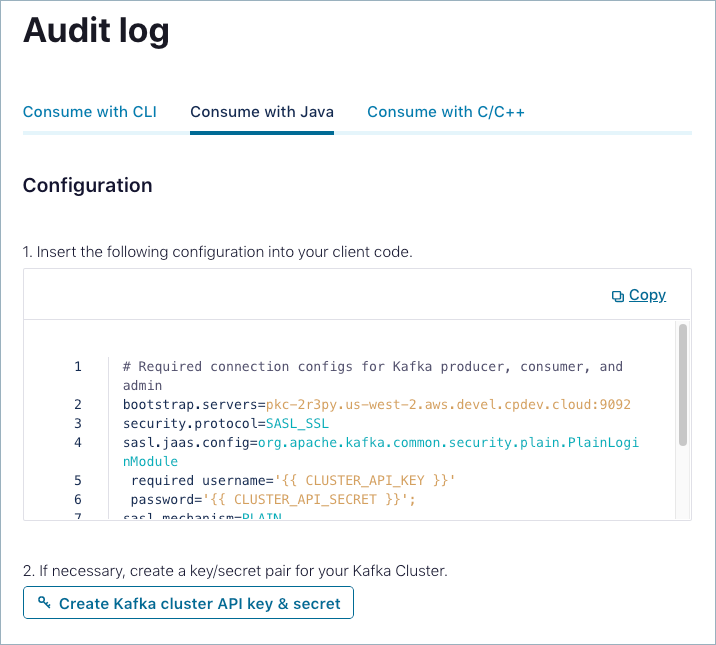

監査ログページの Consume with Java タブをクリックします。

表示された構成をクライアントにコピーアンドペーストします。

必要に応じて Create Kafka cluster API key & secret をクリックして、Kafka クラスターに使用するキーとシークレットのペアを作成します。

Java クライアントを起動して接続します。

C/C++ を使用した消費¶

https://confluent.cloud で Confluent Cloud Console にサインインします。

ADMINISTRATION、Audit log の順に移動します。

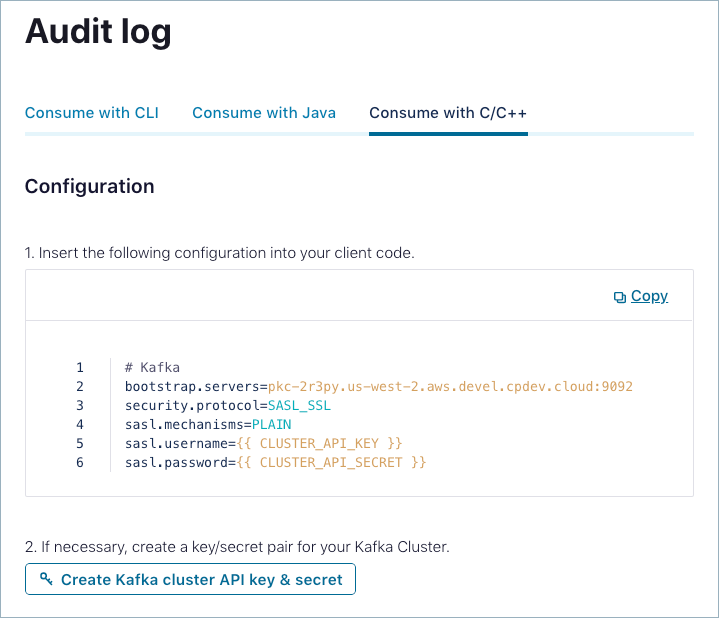

監査ログ ページの Consume with C/C++ タブをクリックします。

表示された構成をクライアントにコピーアンドペーストします。

必要に応じて Create Kafka cluster API key & secret をクリックして、Kafka クラスターに使用する API キーとシークレットを作成します。

C/C++ クライアントを起動して接続します。

Confluent Cloud 監査ログの保護¶

Confluent Cloud 監査ログの送信先クラスターは、AWS us-west-2 のパブリッククラスターに置かれます。ストレージは暗号化されており、また、KMS によって管理されるデフォルトのキーローテーションスケジュール(3 年おき)が使用されます。監査ログクラスターに固有の API キーが、読み取り専用アクセス権を取得する唯一の手段となります。

組織の監査ログは、その読み取りに使用する API キーを保護することでセキュリティを確保します。

前述のように、Confluent Cloud はアクティブな監査ログクラスターの API キーを 2 つまでサポートするため、ライブキーローテーションに対応できます。API キーのベストプラクティスについては、「API キーを使用するためのベストプラクティス」を参照してください。

ファイアウォールの内側からの監査ログメッセージへのアクセス¶

Like other Confluent Cloud public clusters, audit log clusters do not have a static IP address. To access your audit log messages, you must move your consumer outside the firewall. For details about configuring access to the Confluent Cloud Console, see Access Confluent Cloud Console with Private Networking.