重要

このページの日本語コンテンツは古くなっている可能性があります。最新の英語版コンテンツをご覧になるには、こちらをクリックしてください。

Azure Event Hubs Source Connector for Confluent Cloud¶

注釈

Confluent Platform 用にコネクターをローカルにインストールする場合は、「Azure Event Hubs Source Connector for Confluent Platform」を参照してください。

Kafka Connect Azure Event Hubs Source Connector for Confluent Cloud を使用すると、Azure Event Hubs のデータをポーリングして、そのデータを Apache Kafka® トピックに保存することができます。Azure Event Hubs の詳細については、Azure Event Hubs のドキュメント を参照してください。このコネクターはサブスクリプションを介して Azure Event Hubs からレコードをフェッチします。

機能¶

Azure Event Hubs Source Connector には、以下の機能があります。

- トピックの自動作成: このコネクターは Kafka トピックを自動的に作成できます。

- 厳選された構成プロパティ:

azure.eventhubs.partition.starting.positionazure.eventhubs.consumer.groupazure.eventhubs.transport.typeazure.eventhubs.offset.typemax.events(デフォルトは 50 です。最大イベント数は 499 です)

Connect 用の Confluent Cloud API の使用に関する詳細とサンプルについては、「Confluent Cloud API for Connect」セクションを参照してください。

制限¶

以下の情報を確認してください。

- コネクターの制限事項については、Azure Event Hubs Source Connector の制限事項を参照してください。

- 1 つ以上の Single Message Transforms(SMT)を使用する場合は、「SMT の制限」を参照してください。

- Confluent Cloud Schema Registry を使用する場合は、「スキーマレジストリ Enabled Environments」を参照してください。

クイックスタート¶

このクイックスタートを使用して、Confluent Cloud Azure Event Hubs Source Connector の利用を開始することができます。

- 前提条件

- アマゾンウェブサービス (AWS)、Microsoft Azure (Azure)、または Google Cloud Platform (GCP)上の Confluent Cloud クラスターへのアクセスを許可されていること。

- コネクターを作成する前に、トピックが 1 つ以上存在している必要があります。

- Confluent CLI がインストールされ、クラスター用に構成されていること。「Confluent CLI のインストール」を参照してください。

- 既存の Event Hubs 名前空間、イベントハブ、およびコンシューマーグループがある Azure アカウント。

- ポリシー名とキーを構成した Azure Event Hubs 共有アクセスポリシー。

- Kafka クラスターの認証情報。次のいずれかの方法で認証情報を指定できます。

- 既存の サービスアカウント のリソース ID を入力する。

- コネクター用の Confluent Cloud サービスアカウント を作成します。「サービスアカウント」のドキュメントで、必要な ACL エントリを確認してください。一部のコネクターには固有の ACL 要件があります。

- Confluent Cloud の API キーとシークレットを作成する。キーとシークレットを作成するには、confluent api-key create を使用するか、コネクターのセットアップ時に Cloud Console で直接 API キーとシークレットを自動生成します。

Confluent Cloud Console の使用¶

ステップ 1: Confluent Cloud クラスターを起動します。¶

インストール手順については、「Quick Start for Confluent Cloud」を参照してください。

ステップ 2: コネクターを追加します。¶

左のナビゲーションメニューの Data integration をクリックし、Connectors をクリックします。クラスター内に既にコネクターがある場合は、+ Add connector をクリックします。

Step 4: Enter the connector details.¶

注釈

- すべての 前提条件 を満たしていることを確認してください。

- アスタリスク( * )は必須項目であることを示しています。

At the Add Azure Event Hubs Source Connector screen, complete the following:

- Select the way you want to provide Kafka Cluster credentials. You can

choose one of the following options:

- Global Access: Allows your connector to access everything you have access to. With global access, connector access will be linked to your account. This option is not recommended for production.

- Granular access: Limits the access for your connector. You will be able to manage connector access through a service account. This option is recommended for production.

- Use an existing API key: Allows you to enter an API key and secret part you have stored. You can enter an API key and secret (or generate these in the Cloud Console).

- Click Continue.

- Enter your Azure Event Hubs details.

- Shared access policy namee: Shared access policy name to use for access authentication.

- Shared access key: Shared access key to use for access authentication.

- Event Hubs namespace: Event Hubs namespace to connect to.

- Event Hub name: Event Hub to read from.

- Azure Event Hubs consumer group: Specific consumer group to read from.

- Click Continue.

(Optional) Configure the following properties:

Show advanced configurations

Default starting position: Default reset position if no offsets are stored.

Azure Event Hubs transport type: Event Hubs commnunication transport type.

Azure Event Hubs offset type: Offset type to use to keep track of events.

Max eventsr: Maximum number of events to read when polling an Event Hub partition.

Transforms and Predicates: 詳細については、Single Message Transforms(SMT) のドキュメントを参照してください。

Click Continue

Based on the number of topic partitions you select, you will be provided with a recommended number of tasks.

- To change the number of tasks, use the Range Slider to select the desired number of tasks.

- Click Continue.

Step 5: Check the Kafka topic.¶

コネクターが実行中になったら、メッセージが Kafka トピックに取り込まれていることを確認します。

Connect 用の Confluent Cloud API の使用に関する詳細とサンプルについては、「Confluent Cloud API for Connect」セクションを参照してください。

参考

フルマネージド型の Confluent Cloud コネクターが Confluent Cloud ksqlDB でどのように動作するかを示す例については、「Cloud ETL のデモ」を参照してください。この例では、Confluent CLI を使用して Confluent Cloud のリソースを管理する方法についても説明しています。

Confluent CLI を使用する場合¶

以下の手順に従うと、Confluent CLI を使用してコネクターをセットアップし、実行できます。

重要

すべての 前提条件 を満たしていることを確認してください。

コマンド例では Confluent CLI バージョン 2 を使用しています。詳細については、「Confluent CLI v2 への移行」を参照してください。

このコネクターを作成して起動する前に、トピック名を作成しておく必要があります。Confluent CLI を使用してトピックを作成するには、以下のコマンドを使用します。

confluent kafka topic create <topic-name>

ステップ 2: コネクターの必須の構成プロパティを表示します。¶

以下のコマンドを実行して、コネクターの必須プロパティを表示します。

confluent connect plugin describe <connector-catalog-name>

例:

confluent connect plugin describe AzureEventHubsSource

出力例:

Following are the required configs:

connector.class: AzureEventHubsSource

name

kafka.auth.mode

kafka.api.key

kafka.api.secret

azure.eventhubs.sas.keyname

azure.eventhubs.sas.key

azure.eventhubs.namespace

azure.eventhubs.hub.name

kafka.topic

tasks.max

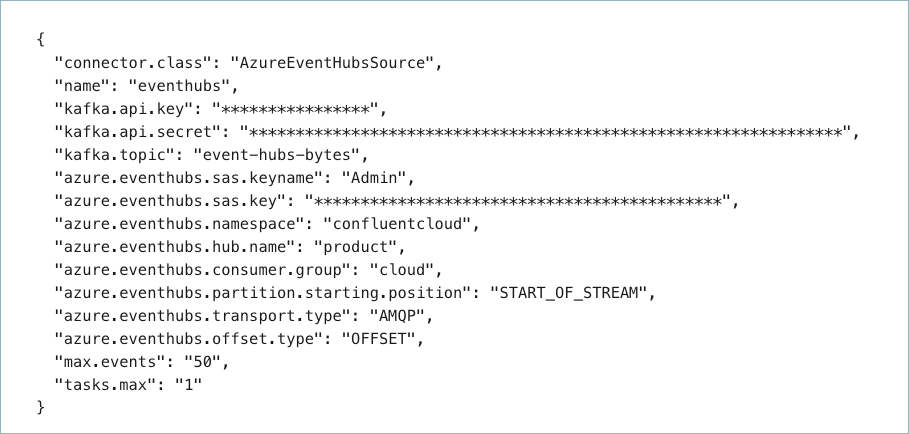

ステップ 3: コネクターの構成ファイルを作成します。¶

コネクター構成プロパティを含む JSON ファイルを作成します。以下の例は、コネクターの必須プロパティとオプションのプロパティを示しています。

{

"connector.class": "AzureEventHubsSource",

"name": "azure-eventhubs-source",

"kafka.auth.mode": "KAFKA_API_KEY",

"kafka.api.key": "<my-kafka-api-key>",

"kafka.api.secret": "<my-kafka-api-secret>",

"azure.eventhubs.sas.keyname": "<-my-shared-access-policy name->",

"azure.eventhubs.sas.key": "<my-shared-access-key>",

"azure.eventhubs.namespace": "<my-eventhubs-namespace>",

"azure.eventhubs.hub.name": "<my-eventhub-name>",

"azure.eventhubs.consumer.group": "<my-eventhub-consumer-group>",

"kafka.topic": "<my-topic-name>",

"azure.eventhubs.partition.starting.position": "START_OF_STREAM",

"azure.eventhubs.transport.type": "AMQP",

"azure.eventhubs.offset.type": "OFFSET",

"max.events": "50",

"tasks.max": "1"

}

以下のプロパティ定義に注意してください。

"name": 新しいコネクターの名前を設定します。"connector.class": コネクターのプラグイン名を指定します。

"kafka.auth.mode": 使用するコネクターの認証モードを指定します。オプションはSERVICE_ACCOUNTまたはKAFKA_API_KEY(デフォルト)です。API キーとシークレットを使用するには、構成プロパティkafka.api.keyとkafka.api.secretを構成例(前述)のように指定します。サービスアカウント を使用するには、プロパティkafka.service.account.id=<service-account-resource-ID>に リソース ID を指定します。使用できるサービスアカウントのリソース ID のリストを表示するには、次のコマンドを使用します。confluent iam service-account list

例:

confluent iam service-account list Id | Resource ID | Name | Description +---------+-------------+-------------------+------------------- 123456 | sa-l1r23m | sa-1 | Service account 1 789101 | sa-l4d56p | sa-2 | Service account 2

"azure.eventhubs.partition.starting.position":(オプション)オフセットが保管されていないためにリセットが発生した場合に使用するイベントハブの開始位置を設定します。値は、START_OF_STREAMまたはEND_OF_STREAMです。プロパティを入力しない場合は、START_OF_STREAMがデフォルトとして構成されます。注釈

The Azure Event Hub Source connector uses

x-opt-kafka-keykey-value pair as the partition key when the Azure SDKEventData.PartitionKeyproperty is null and when thex-opt-kafka-keyis present."azure.eventhubs.transport.type":(オプション)|az| Event Hubs との通信に使用するトランスポートの種類を設定します。値は、AMQPまたはAMQP_WEB_SOCKETSです。AMQP(over TCP)ではポート 5671 が使用されます。AMQP over Web Sockets ではポート 443 が使用されます。プロパティを入力しない場合は、AMQPがデフォルトとして構成されます。"azure.eventhubs.offset.type":(オプション)イベントの追跡に使用するオフセットの種類を設定します。値は、OFFSET(イベントを表す Azure Event Hubs オフセット)またはSEQ_NUM(イベントのシーケンス番号)です。プロパティを入力しない場合、OFFSETがデフォルトとして構成されます。"max.events":(オプション)ポーリング時にイベントハブのパーティションから読み込むイベントの最大数。プロパティを入力しない場合は、50がデフォルトとして構成されます。イベントの最大数は499です。

Single Message Transforms: See the Single Message Transforms (SMT) documentation for details about adding SMTs. See サポートされない変換 for a list of SMTs that are not supported with this connector.

すべてのプロパティの値と定義については、「構成プロパティ」を参照してください。

ステップ 4: プロパティファイルを読み込み、コネクターを作成します。¶

以下のコマンドを入力して、構成を読み込み、コネクターを起動します。

confluent connect create --config <file-name>.json

例:

confluent connect create --config az-event-hubs.json

出力例:

Created connector azure-eventhubs-source lcc-ix4dl

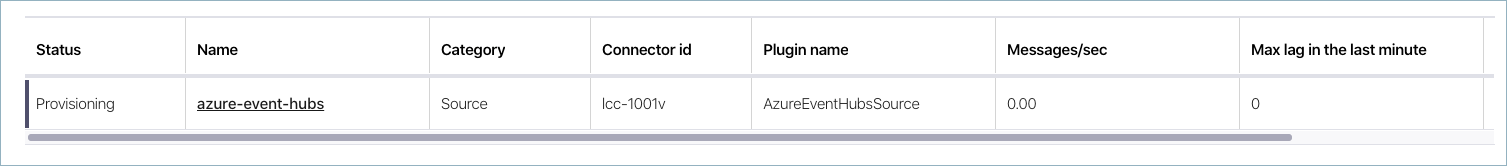

ステップ 5: コネクターのステータスを確認します。¶

以下のコマンドを入力して、コネクターのステータスを確認します。

confluent connect list

出力例:

ID | Name | Status | Type

+-----------+--------------------------+---------+--------+

lcc-ix4dl | azure-eventhubs-source | RUNNING | source

ステップ 6: Kafka トピックを確認します。¶

コネクターが実行中になったら、メッセージが Kafka トピックに取り込まれていることを確認します。

Connect 用の Confluent Cloud API の使用に関する詳細とサンプルについては、「Confluent Cloud API for Connect」セクションを参照してください。

構成プロパティ¶

このコネクターでは、以下のコネクター構成プロパティを使用します。

データへの接続方法(How should we connect to your data?)¶

nameコネクターの名前を設定します。

- 型: string

- 指定可能な値: 最大 64 文字の文字列

- 重要度: 高

Kafka クラスターの認証情報(Kafka Cluster credentials)¶

kafka.auth.modeKafka の認証モード。KAFKA_API_KEY または SERVICE_ACCOUNT を指定できます。デフォルトは KAFKA_API_KEY モードです。

- 型: string

- デフォルト: KAFKA_API_KEY

- 指定可能な値: KAFKA_API_KEY、SERVICE_ACCOUNT

- 重要度: 高

kafka.api.key- 型: password

- 重要度: 高

kafka.service.account.idKafka クラスターとの通信用の API キーを生成するために使用されるサービスアカウント。

- 型: string

- 重要度: 高

kafka.api.secret- 型: password

- 重要度: 高

データの送信先トピック(Which topic do you want to send data to?)¶

kafka.topicデータの書き込み先トピック名を指定します。

- 型: string

- 重要度: 高

イベントハブへの接続方法(How should we connect to your Event Hub?)¶

azure.eventhubs.sas.keynameアクセス認証に使用する共有アクセスポリシー名。

- 型: string

- 重要度: 高

azure.eventhubs.sas.keyアクセス認証に使用する共有アクセスキー。

- 型: password

- 重要度: 高

azure.eventhubs.namespace接続先イベントハブの名前空間。

- 型: string

- 重要度: 高

azure.eventhubs.hub.name読み取り元イベントハブ。

- 型: string

- 重要度: 高

azure.eventhubs.consumer.group読み取り元のコンシューマーグループを指定します。

- 型: string

- デフォルト: $Default

- 重要度: 低

接続の詳細(Connection details)¶

azure.eventhubs.partition.starting.positionオフセットが保管されていない場合のデフォルトのリセット位置。

- 型: string

- デフォルト: START_OF_STREAM

- 重要度: 中

azure.eventhubs.transport.typeイベントハブの通信用トランスポートの種類。

- 型: string

- デフォルト: AMQP

- 重要度: 低

azure.eventhubs.offset.typeイベントの追跡に使用するオフセットの種類

- 型: string

- デフォルト: OFFSET

- 重要度: 中

max.eventsイベントハブのパーティションをポーリングするときに読み取るイベントの最大数。

- 型: int

- デフォルト: 50

- 指定可能な値: [1、…、500]

- 重要度: 低

このコネクターのタスク数(Number of tasks for this connector)¶

tasks.max- 型: int

- 指定可能な値: [1、…]

- 重要度: 高

次のステップ¶

参考

フルマネージド型の Confluent Cloud コネクターが Confluent Cloud ksqlDB でどのように動作するかを示す例については、「Cloud ETL のデモ」を参照してください。この例では、Confluent CLI を使用して Confluent Cloud のリソースを管理する方法についても説明しています。