重要

このページの日本語コンテンツは古くなっている可能性があります。最新の英語版コンテンツをご覧になるには、こちらをクリックしてください。

ServiceNow Sink Connector for Confluent Cloud¶

注釈

Confluent Platform 用にコネクターをローカルにインストールする場合は、「ServiceNow Sink Connector for Confluent Platform」を参照してください。

Kafka Connect ServiceNow Sink Connector for Confluent Cloud は、Apache Kafka® のレコードをキャプチャーして ServiceNow テーブル にリアルタイムでシンクするために使用されます。データは、ServiceNow Table API を使用して消費されます。

機能¶

ServiceNow Sink Connector は、次の機能をサポートしています。

少なくとも 1 回のデリバリー: コネクターによって、Kafka のトピックからのレコードが少なくとも 1 回は配信されることが保証されます。

複数のタスクのサポート: このコネクターは、1 つまたは複数のタスクの実行をサポートしています。タスクが多いほどパフォーマンスが向上する可能性があります。

トピックの自動作成: コネクターの起動時に、以下の 3 つのトピックが自動的に作成されます。

- 成功トピック

- エラートピック

- デッドレターキュー(DLQ)トピック

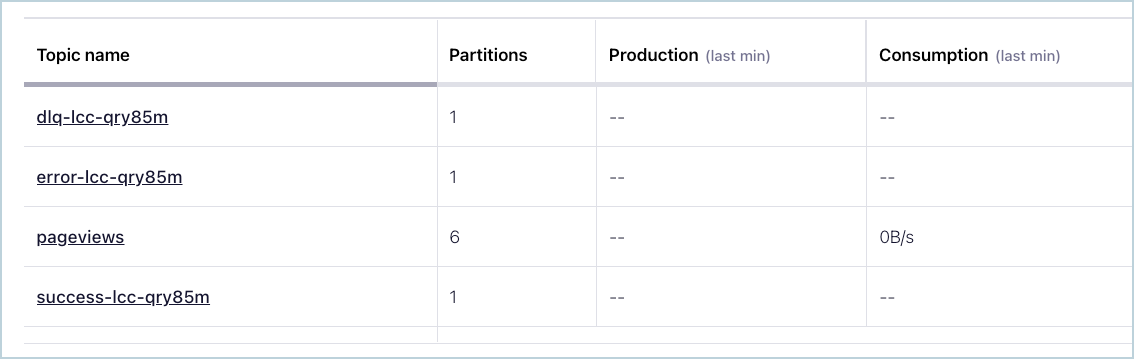

各トピック名にはサフィックスとして、コネクターの論理 ID が付けられます。以下の例では、コネクターのトピックが 3 つと、pageviews という名前の既存の Kafka トピックが 1 つ含まれています。

コネクターのトピック¶

トピックに送信されたレコードが正しいフォーマットではない場合、またはレコード内に重要なフィールドが存在しない場合は、エラートピックにエラーが記録され、コネクターは動作を継続します。

サポートされるデータフォーマット: このコネクターは、Avro、JSON スキーマ(JSON-SR)、および Protobuf 入力フォーマットをサポートします。これらの スキーマレジストリ ベースのフォーマットを使用するには、Schema Registry を有効にしておく必要があります。

Connect 用の Confluent Cloud API の使用に関する詳細とサンプルについては、「Confluent Cloud API for Connect」セクションを参照してください。

制限¶

以下の情報を確認してください。

- 1 つ以上の Single Message Transforms(SMT)を使用する場合は、「SMT の制限」を参照してください。

- Confluent Cloud Schema Registry を使用する場合は、「スキーマレジストリ Enabled Environments」を参照してください。

クイックスタート¶

このクイックスタートを使用して、Confluent Cloud ServiceNow Sink Connector の利用を開始することができます。このクイックスタートでは、コネクターを選択し、イベントをストリーミングするようにコネクターを構成するための基本的な方法について説明します。

- 前提条件

- アマゾンウェブサービス (AWS)、Microsoft Azure (Azure)、または Google Cloud Platform (GCP)上の Confluent Cloud クラスターへのアクセスを許可されていること。

- コネクターで使用する、認可された ServiceNow ユーザーと認証情報。

- Confluent CLI がインストールされ、クラスター用に構成されていること。「Confluent CLI のインストール」を参照してください。

- スキーマレジストリ ベースのフォーマット(Avro、JSON_SR(JSON スキーマ)、Protobuf など)を使用するには、Schema Registry を有効にしておく必要があります。詳細については、「スキーマレジストリ Enabled Environments」を参照してください。

- シンクコネクターを作成する前に、Confluent Cloud クラスター上にソース Kafka トピックが 1 つ以上存在している必要があります。

Confluent Cloud Console の使用¶

ステップ 1: Confluent Cloud クラスターを起動します。¶

インストール手順については、「Quick Start for Confluent Cloud」を参照してください。

ステップ 2: コネクターを追加します。¶

左のナビゲーションメニューの Data integration をクリックし、Connectors をクリックします。クラスター内に既にコネクターがある場合は、+ Add connector をクリックします。

ステップ 4: コネクターの詳細情報を入力します。¶

注釈

- すべての 前提条件 を満たしていることを確認してください。

- アスタリスク(* )は必須項目であることを示しています。

Add ServiceNow Sink Connector 画面で、以下を実行します。

既に Kafka トピックを用意している場合は、Topics リストから接続するトピックを選択します。

新しいトピックを作成するには、+Add new topic をクリックします。

- Kafka Cluster credentials で Kafka クラスターの認証情報の指定方法を選択します。以下のいずれかのオプションを選択できます。

- Global Access: コネクターは、ユーザーがアクセス権限を持つすべての対象にアクセスできます。グローバルアクセスの場合、コネクターのアクセス権限は、ユーザーのアカウントにリンクされます。このオプションは本稼働環境では推奨されません。

- Granular access: コネクターのアクセスが制限されます。コネクターのアクセス権限は サービスアカウント から制御できます。本稼働環境にはこのオプションをお勧めします。

- Use an existing API key: 保存済みの API キーおよびシークレット部分を入力できます。API キーとシークレットを入力するか Cloud Console でこれらを生成することもできます。

- Continue をクリックします。

- ServiceNow Instance URL フィールドに、ServiceNow インスタンスの URL を

https://dev1000.service-now.com/という形式で入力します。 - ServiceNow table name フィールドに ServiceNow テーブル名を入力します。

- ServiceNow Username フィールドに ServiceNow の基本認証のユーザー名を入力します。

- ServiceNow Password フィールドに ServiceNow の基本認証のパスワードを入力します。

- Continue をクリックします。

注釈

Cloud Console に表示されない構成プロパティでは、デフォルト値が使用されます。すべてのプロパティの値と定義については、「構成プロパティ」を参照してください。

Input Kafka record value で、Kafka 入力レコード値のフォーマット(Kafka トピックから送られるデータ)を AVRO、JSON_SR、または PROTOBUF から選択します。スキーマベースのメッセージフォーマット(Avro、JSON スキーマ、Protobuf など)を使用するには、有効なスキーマが Schema Registry に存在する必要があります。

Show advanced configurations

HTTP request timeout (ms): HTTP リクエストのタイムアウト(ミリ秒)。

Maximum number of times to retry request: リクエストを再試行する最大回数。

Transforms and Predicates: 詳細については、Single Message Transforms(SMT) のドキュメントを参照してください。

すべてのプロパティの値と定義については、「構成プロパティ」を参照してください。

Continue をクリックします。

選択するトピックのパーティション数に基づいて、推奨タスク数が表示されます。

- 推奨されたタスク数を変更するには、Tasks フィールドに、コネクターで使用する タスク の数を入力します。

- Continue をクリックします。

接続の詳細情報を確認します。

Launch をクリックします。

コネクターのステータスが Provisioning から Running に変わります。

ステップ 5: レコードを確認します。¶

ServiceNow テーブルがアップデートされているかを検証します。

Connect 用の Confluent Cloud API の使用に関する詳細とサンプルについては、「Confluent Cloud API for Connect」セクションを参照してください。

ちなみに

コネクターを起動すると、デッドレターキューのトピックが自動的に作成されます。詳細については、「Confluent Cloud デッドレターキュー」を参照してください。

Confluent CLI の使用¶

以下の手順に従うと、Confluent CLI を使用してコネクターをセットアップし、実行できます。

注釈

- すべての 前提条件 を満たしていることを確認してください。

- コマンド例では Confluent CLI バージョン 2 を使用しています。詳細については、「Confluent CLI v2 への移行 <https://docs.confluent.io/confluent-cli/current/migrate.html#cli-migrate>`__」を参照してください。

ステップ 2: コネクターの必須の構成プロパティを表示します。¶

以下のコマンドを実行して、コネクターの必須プロパティを表示します。

confluent connect plugin describe <connector-catalog-name>

例:

confluent connect plugin describe ServiceNowSink

出力例:

Following are the required configs:

connector.class: ServiceNowSink

input.data.format

name

kafka.auth.mode

kafka.api.key

kafka.api.secret

servicenow.url

servicenow.table

servicenow.user

servicenow.password

topics

ステップ 3: コネクターの構成ファイルを作成します。¶

コネクター構成プロパティを含む JSON ファイルを作成します。以下の例は、コネクターの必須プロパティを示しています。

{

"connector.class": "ServiceNowSink",

"input.data.format": "AVRO",

"name": "ServiceNowSink_0",

"kafka.auth.mode": "KAFKA_API_KEY",

"kafka.api.key": "****************",

"kafka.api.secret": "************************************************",

"servicenow.url": "<servicenow-URL>",

"servicenow.table": "<table-name>",

"servicenow.user": "<authorized-username>",

"servicenow.password": "<user-password>",

"tasks.max": "1",

"topics": "orders"

}

以下のプロパティ定義に注意してください。

"connector.class": コネクターのプラグイン名を指定します。"input.data.format": Kafka 入力レコード値のフォーマット(Kafka トピックから送られるデータ)を設定します。指定可能なエントリは、AVRO、JSON_SR、および PROTOBUF です。スキーマベースのメッセージフォーマット(たとえば、Avro、JSON_SR(JSON スキーマ)、および Protobuf)を使用するには、Confluent Cloud Schema Registry を構成しておく必要があります。"name": 新しいコネクターの名前を設定します。

"kafka.auth.mode": 使用するコネクターの認証モードを指定します。オプションはSERVICE_ACCOUNTまたはKAFKA_API_KEY(デフォルト)です。API キーとシークレットを使用するには、構成プロパティkafka.api.keyとkafka.api.secretを構成例(前述)のように指定します。サービスアカウント を使用するには、プロパティkafka.service.account.id=<service-account-resource-ID>に リソース ID を指定します。使用できるサービスアカウントのリソース ID のリストを表示するには、次のコマンドを使用します。confluent iam service-account list

例:

confluent iam service-account list Id | Resource ID | Name | Description +---------+-------------+-------------------+------------------- 123456 | sa-l1r23m | sa-1 | Service account 1 789101 | sa-l4d56p | sa-2 | Service account 2

servicenow.<>必須の ServiceNow 接続の詳細情報。URL は、https://dev1000.service-now.com/という形式にする必要があります。"tasks.max": このコネクターで使用できる タスク の最大数を入力します。タスクが多いほどパフォーマンスが向上する可能性があります。"topics": 特定のトピック名を指定するか、複数のトピック名をコンマ区切りにしたリストを指定します。

Single Message Transforms: CLI を使用する SMT の追加の詳細については、Single Message Transforms(SMT) のドキュメントを参照してください。

すべてのプロパティの値と説明については、「構成プロパティ」を参照してください。

ステップ 4: プロパティファイルを読み込み、コネクターを作成します。¶

以下のコマンドを入力して、構成を読み込み、コネクターを起動します。

confluent connect create --config <file-name>.json

例:

confluent connect create --config servicenow-sink-config.json

出力例:

Created connector ServiceNowSink_0 lcc-do6vzd

ステップ 5: コネクターのステータスを確認します。¶

以下のコマンドを入力して、コネクターのステータスを確認します。

confluent connect list

出力例:

ID | Name | Status | Type | Trace

+------------+----------------------------+---------+------+-------+

lcc-do6vzd | ServiceNowSink_0 | RUNNING | sink | |

ステップ 6: レコードを確認します。¶

ServiceNow テーブルがアップデートされているかを検証します。

Connect 用の Confluent Cloud API の使用に関する詳細とサンプルについては、「Confluent Cloud API for Connect」セクションを参照してください。

ちなみに

コネクターを起動すると、デッドレターキューのトピックが自動的に作成されます。詳細については、「Confluent Cloud デッドレターキュー」を参照してください。

構成プロパティ¶

このコネクターでは、以下のコネクター構成プロパティを使用します。

データの取得元とするトピック(Which topics do you want to get data from?)¶

topics特定のトピック名を指定するか、複数のトピック名をコンマ区切りにしたリストを指定します。

- 型: list

- 重要度: 高

入力メッセージ(Input messages)¶

input.data.formatKafka 入力レコード値のフォーマットを設定します。指定可能なエントリは、AVRO、JSON_SR、および PROTOBUF です。Confluent Cloud Schema Registry を構成しておく必要があります。

- 型: string

- 重要度: 高

データへの接続方法(How should we connect to your data?)¶

nameコネクターの名前を設定します。

- 型: string

- 指定可能な値: 最大 64 文字の文字列

- 重要度: 高

Kafka クラスターの認証情報(Kafka Cluster credentials)¶

kafka.auth.modeKafka の認証モード。KAFKA_API_KEY または SERVICE_ACCOUNT を指定できます。デフォルトは KAFKA_API_KEY モードです。

- 型: string

- デフォルト: KAFKA_API_KEY

- 指定可能な値: KAFKA_API_KEY、SERVICE_ACCOUNT

- 重要度: 高

kafka.api.key- 型: password

- 重要度: 高

kafka.service.account.idKafka クラスターとの通信用の API キーを生成するために使用されるサービスアカウント。

- 型: string

- 重要度: 高

kafka.api.secret- 型: password

- 重要度: 高

ServiceNow の詳細(ServiceNow details)¶

servicenow.urlServiceNow インスタンスの URL。

- 型: string

- 重要度: 高

servicenow.tableServiceNow テーブル名。

- 型: string

- 重要度: 高

servicenow.userServiceNow の基本認証のユーザー名。

- 型: string

- 重要度: 高

servicenow.passwordServiceNow の基本認証のパスワード。

- 型: password

- 重要度: 高

connection.timeout.msHTTP リクエストのタイムアウト(ミリ秒)。

- 型: int

- デフォルト: 50000(50 秒)

- 重要度: 低

retry.max.timesリクエストの再試行の最大回数。

- 型: int

- デフォルト: 3

- 重要度: 低

このコネクターのタスク数(Number of tasks for this connector)¶

tasks.max- 型: int

- 指定可能な値: [1,...]

- 重要度: 高

次のステップ¶

参考

フルマネージド型の Confluent Cloud コネクターが Confluent Cloud ksqlDB でどのように動作するかを示す例については、「Cloud ETL のデモ」を参照してください。この例では、Confluent CLI を使用して Confluent Cloud のリソースを管理する方法についても説明しています。