重要

このページの日本語コンテンツは古くなっている可能性があります。最新の英語版コンテンツをご覧になるには、こちらをクリックしてください。

ストリーム系列¶

ミッションクリティカルなアプリケーションのアップデートを進めたり、データに関する規制やコンプライアンスなどの重要なテーマに関する問題の答えを出したりするには、流れているデータの全体像を簡単に把握できる手段が必要になります。

ストリーム系列では、イベントストリームとデータの関係性がグラフィカルユーザーインターフェイスで表示されます。全体像を確認することも、掘り下げて細部を拡大することもでき、次のような質問の答えが得られます。

- このデータはどこから来たのか。

- どこに送信されるのか。

- どこで、いつ、どのように変換されたのか。

このような質問の答えが得られれば、開発者は見つけたデータを信頼することができ、自分の加える変更によって下流に悪影響や予期しない影響が生じないことを確認するために必要な可視性が得られます。系列グラフ内に直接組み込まれたライブメトリクスとメタデータ検査により、開発者は確認と判断を短時間で行うことができます。

注釈

If you are working with secured data:

- The following tutorial assumes that you have role-based access to the clusters and topics you need.

- The tutorial assumes that you have role-based access to stream lineage. If you do not have this access, stream lineage will not show up as an option on any screen.

- Developer roles do not have access to stream lineage views in and of themselves. To give a developer access to stream lineage, grant them an additional role with stream lineage access such as Operator at the cluster level. To learn more, see Access Control (RBAC) for Stream Lineage and Confluent Cloud でのロールベースアクセス制御(RBAC)の使用.

概要¶

ストリーム系列の表示内容¶

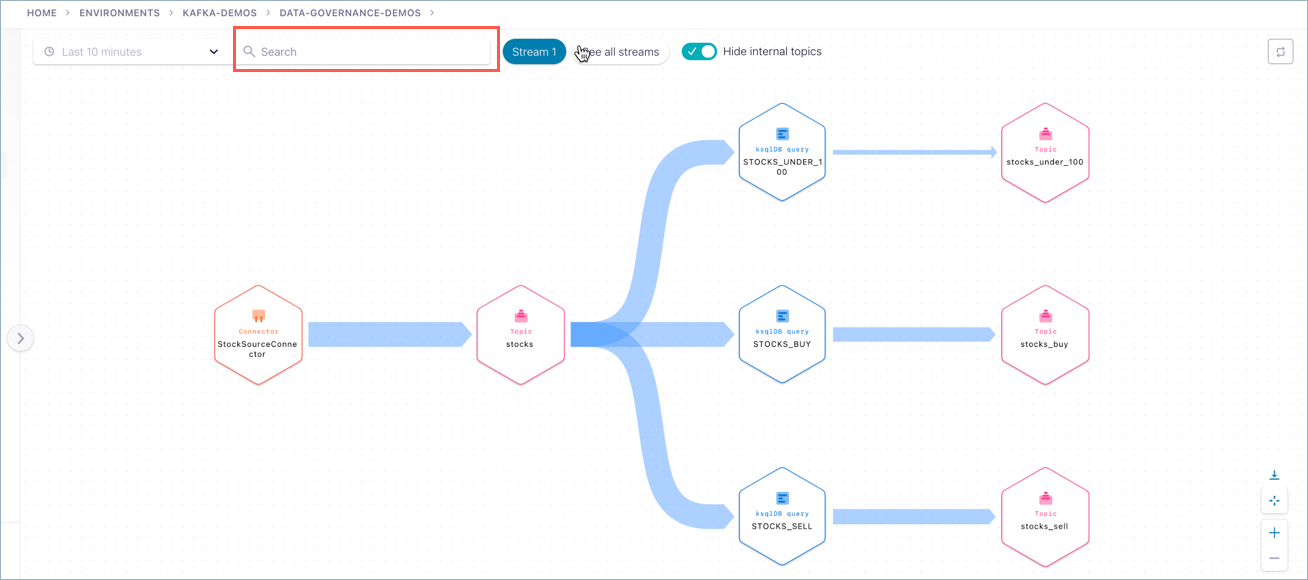

Confluent Cloud ではストリーム系列が視覚的に表示され、送信元から送信先までのデータの移動や移動時に行われたデータ変換を確認できます。系列グラフでは、常に直近 10 分間のデータのプロデューサーおよびコンシューマーのアクティビティが表示されます。

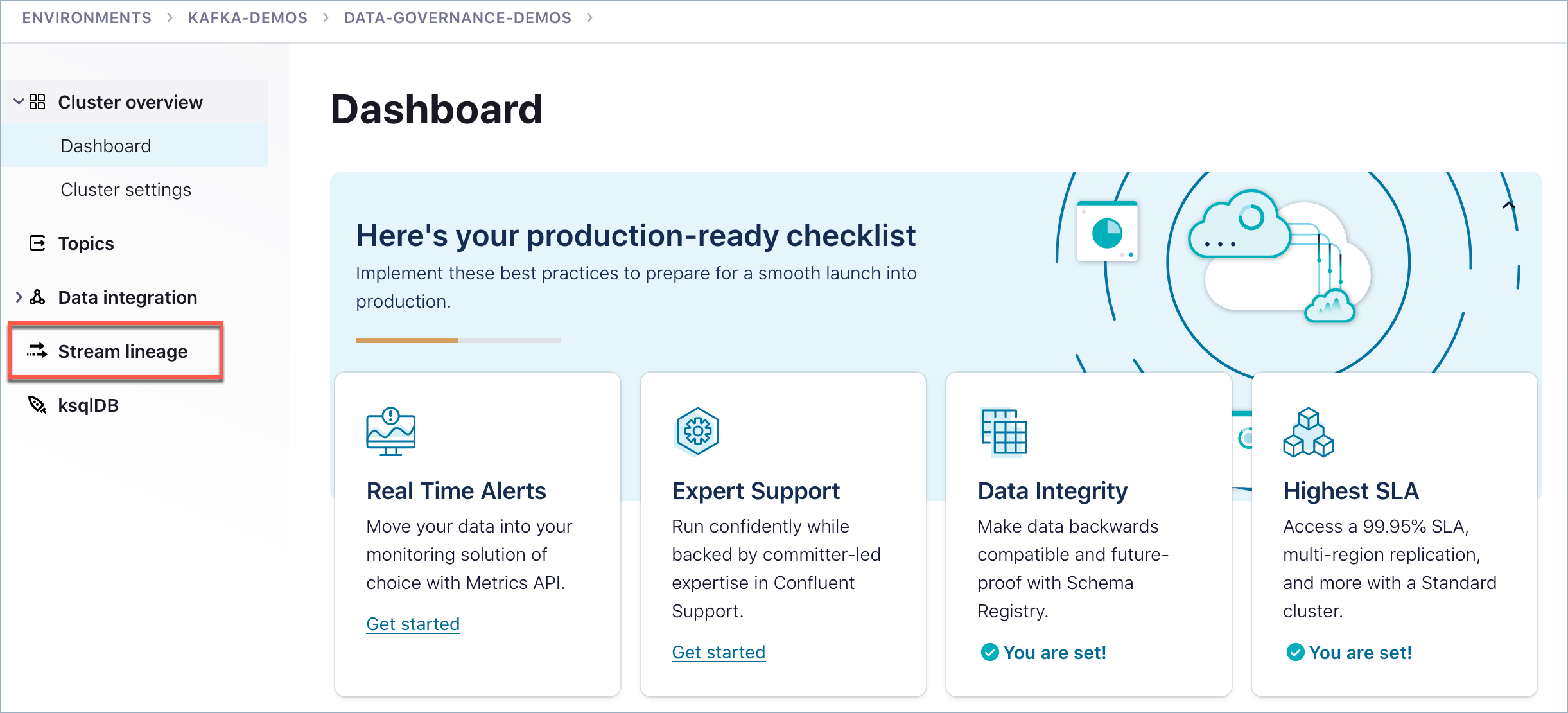

ストリーム系列を表示する方法¶

ストリーム系列の表示に移動するには複数の方法があり、ナビゲーションパスの概要 に記載されています。この例では 1 つのパスを示します。

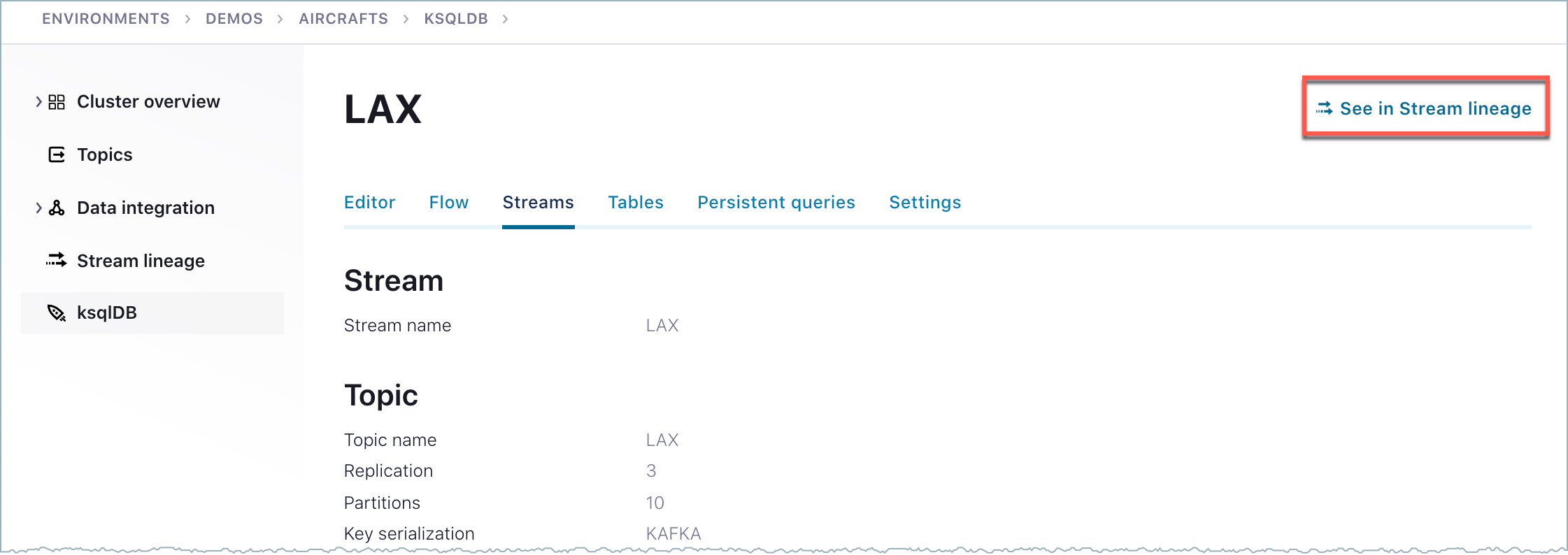

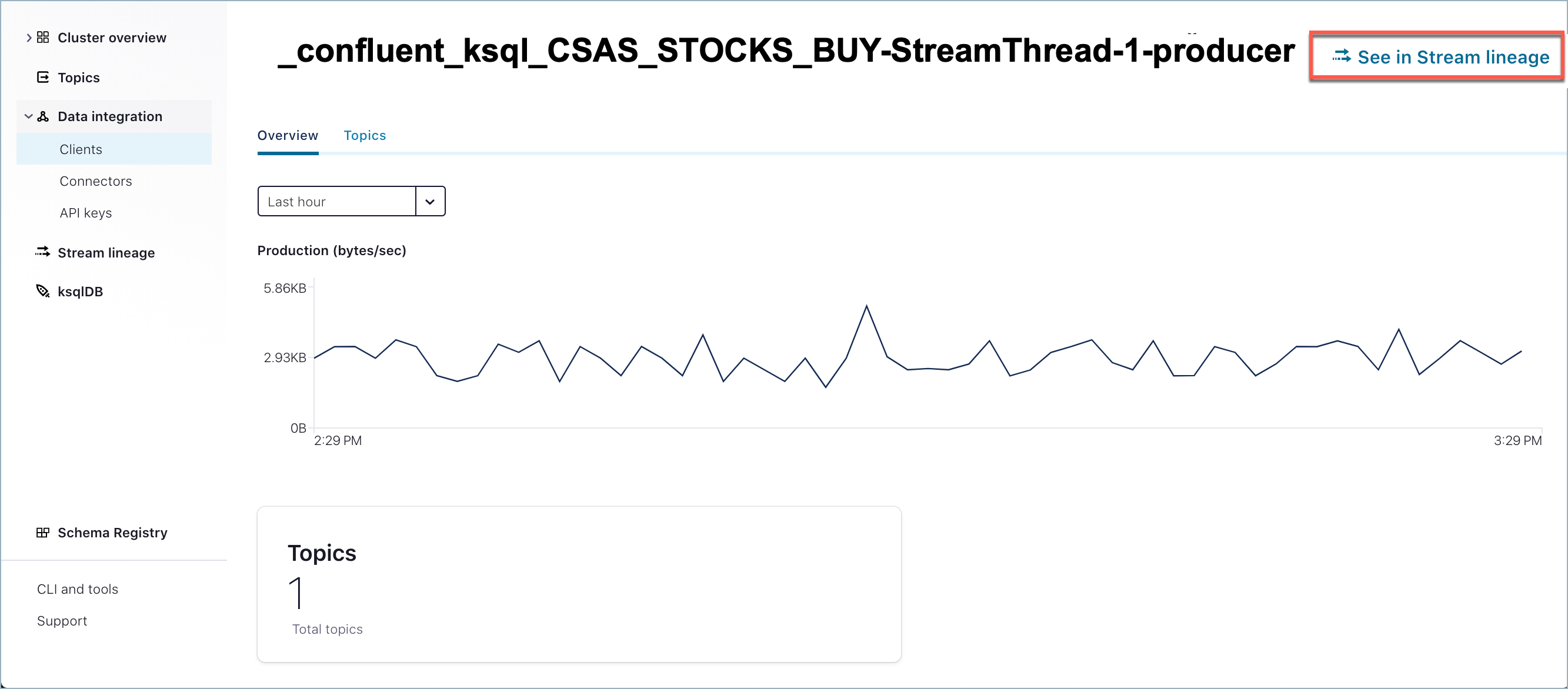

ストリーム系列の UI を表示するには、以下を実行します。

Confluent Cloud にログオンします。

環境を選択します。

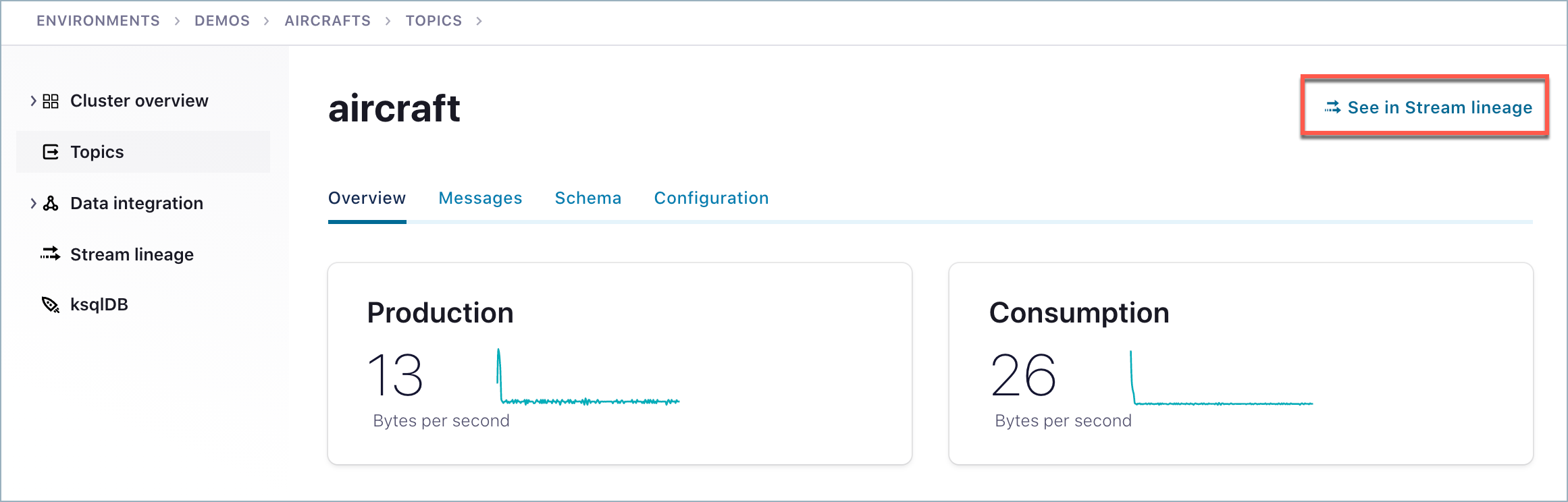

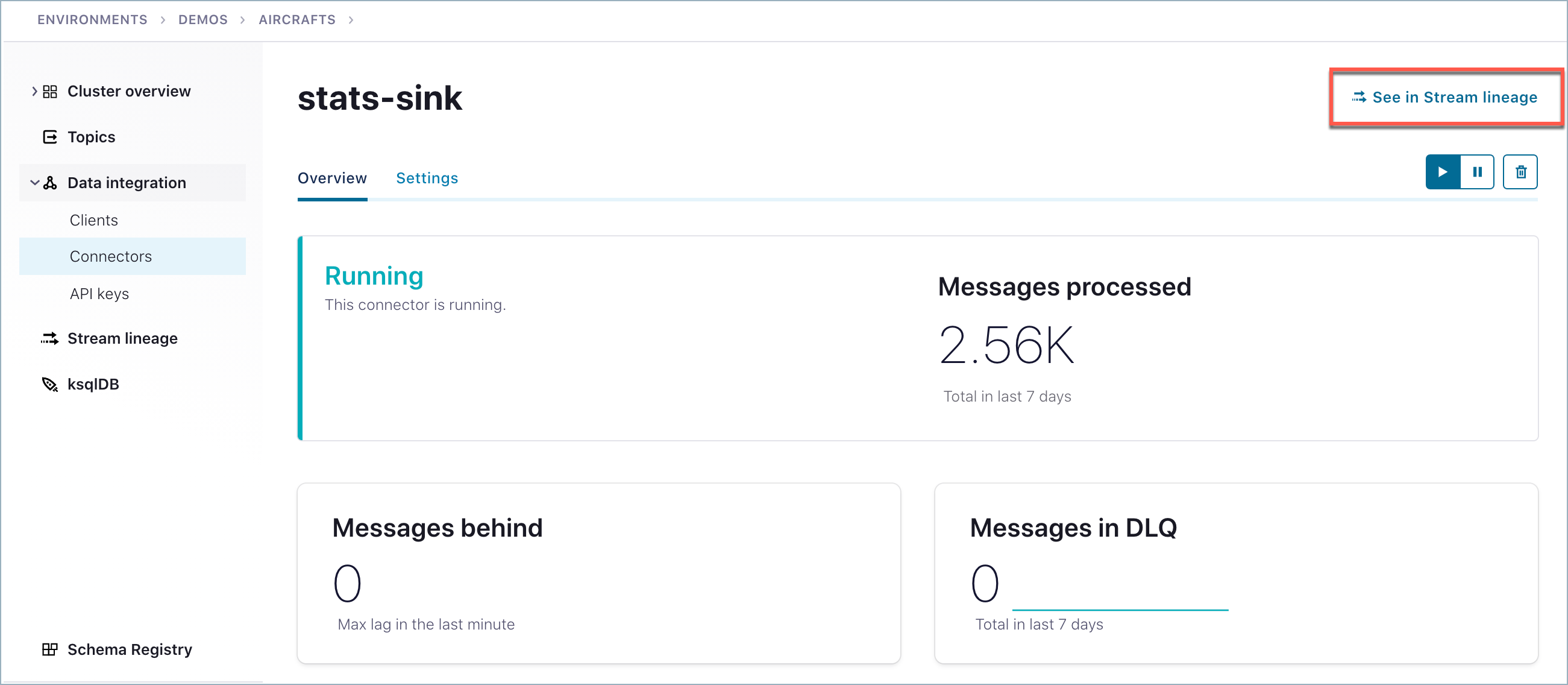

クラスターを選択します。

トピックを選択します。

トピックページの右上にある See in Stream Lineage をクリックします。

ちなみに

If you do not see the option See in Stream Lineage, then you do not have the required permissions. To learn more, see Access Control (RBAC) for Stream Lineage.

そのトピックのストリーム系列が表示されます。

ちなみに

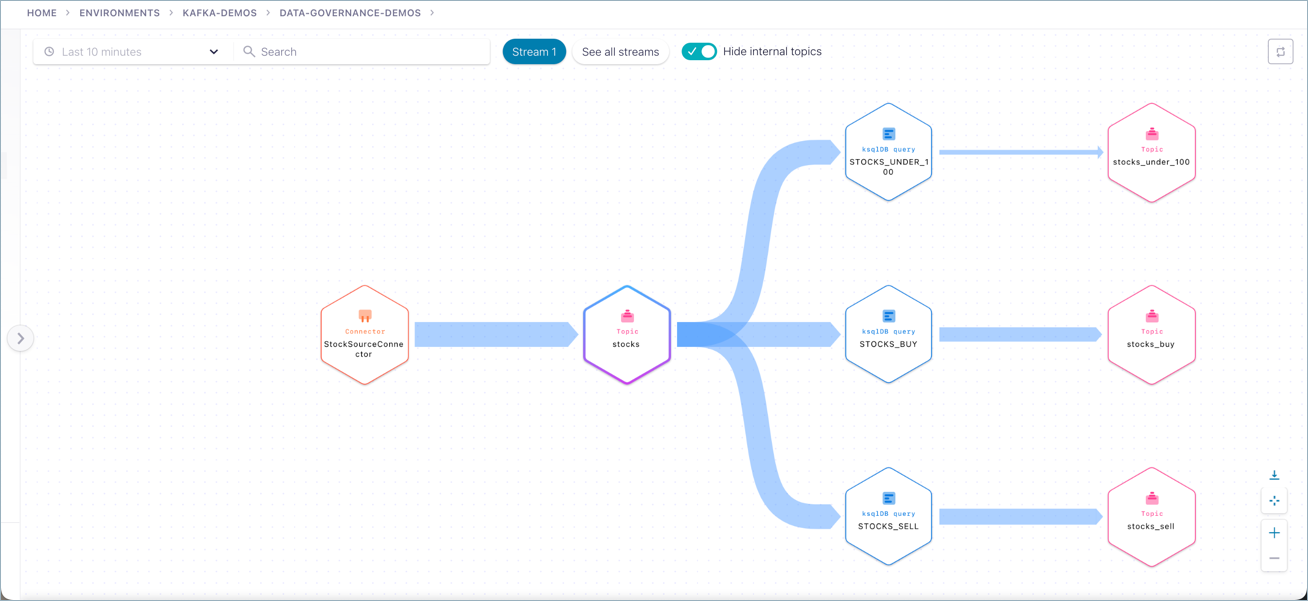

この例に示されているストリーム系列は、複数の ksqlDB クエリストリームを基にしてデータパイプラインをセットアップした結果です。データパイプラインをまだセットアップしていない場合は、系列ビューにイベントノードが 1 つしか表示されない可能性があります。

上のような興味深い系列を表示するには、次のセクションの チュートリアル をお試しください。

チュートリアル¶

ストリーム系列の動作を実際に確認するには、トピック、プロデューサー、コンシューマーを構成してデータパイプラインを作成する必要があります。パイプラインにイベントが流れるようになったら、ストリーム系列を使用して、データの送信元、適用された変換、送信先を確認できます。

環境、クラスター、スキーマレジストリ の選択¶

環境を追加するか、既存の環境を選択します。

デモを実行する クラスターを追加 するか、既存のクラスターを選択します。

新しいクラスターを作成する場合は、以下のようにします。

- クラスタータイプ を選択する必要があります。任意のクラスタータイプを選択できます。

- クラウドプロバイダーとリージョンを選択します。

- Continue をクリックして構成とコスト、使用量の制限、稼働率のサービスレベル契約(SLA)を確認します。

Launch Cluster をクリックします。

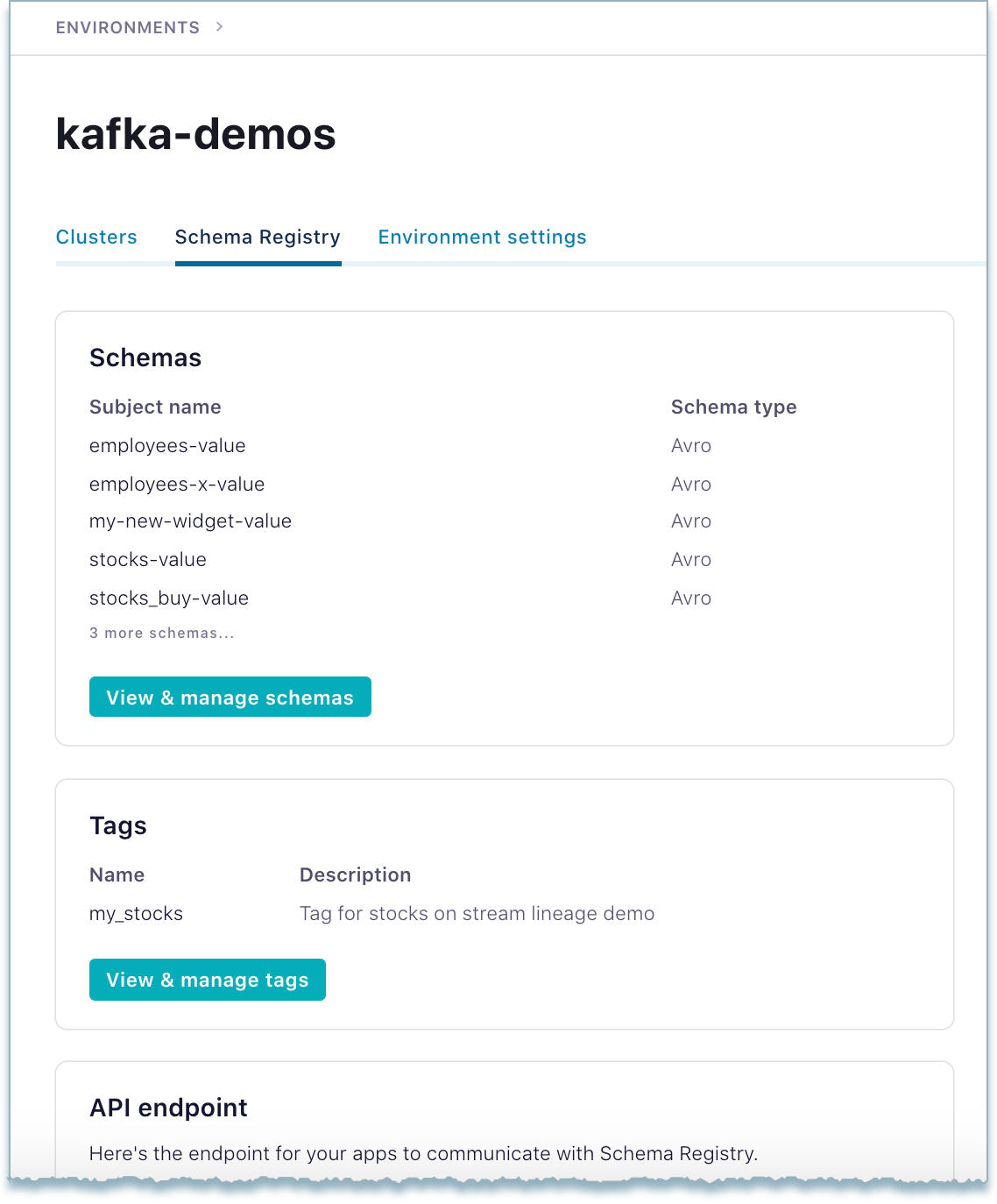

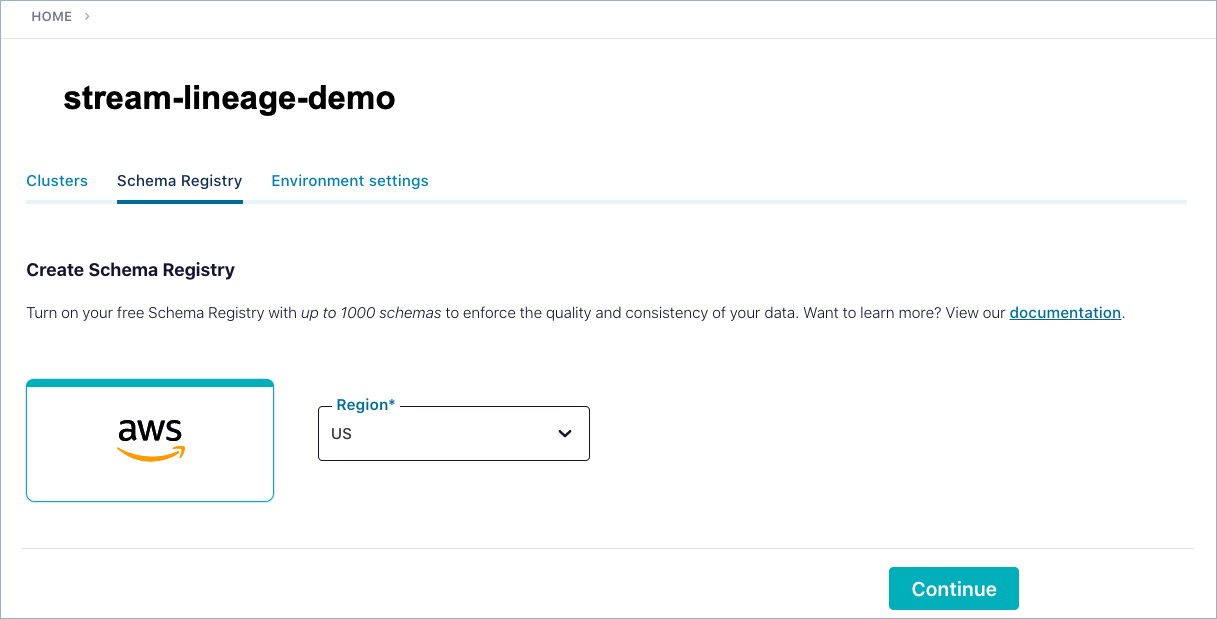

クラスターのスキーマページに移動し、画面の指示に従ってリージョンとクラウドプロバイダーを選択して スキーマレジストリ を有効にします(まだ有効になっていない場合)。

スキーマレジストリ の設定と情報は、環境の スキーマレジストリ のタブで確認できます。

その スキーマレジストリ の スキーマレジストリ API キーとシークレットを生成して保存します。(このキーを、後でこの手順のステップ 10 で使用します。)

ちなみに

これらの初期ステップについてヘルプが必要な場合は、「Quick Start for Confluent Cloud」を参照してください。

"stocks" トピックの作成とデータの生成¶

(省略可)

stocksという名前のトピックを作成します。ちなみに

- このステップは省略可能です。Datagen コネクターを追加すると(この後のステップを参照)、

stocksトピックが自動的に作成されるからです(その時点で存在していなかった場合)。 - トピックを手動で作成して操作する方法の詳細については、「トピックの作成、編集、削除」を参照してください。

- このステップは省略可能です。Datagen コネクターを追加すると(この後のステップを参照)、

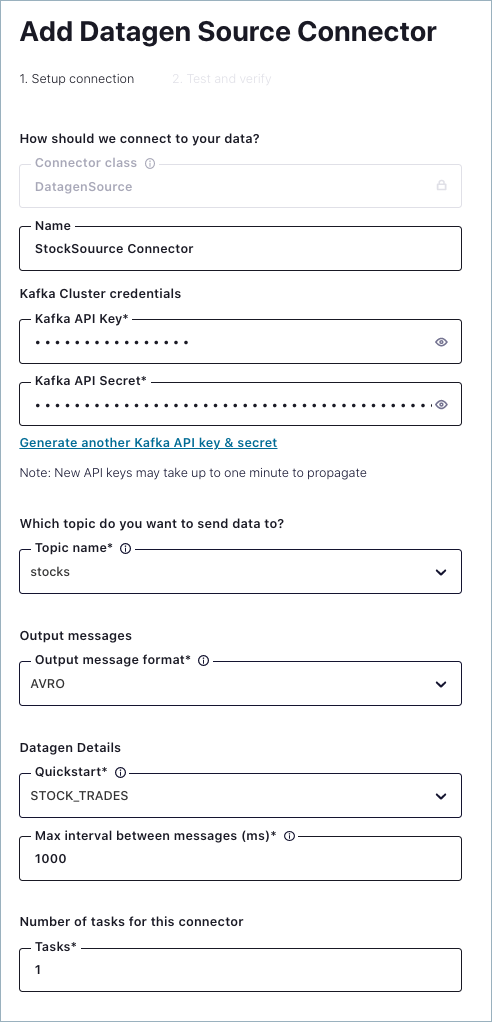

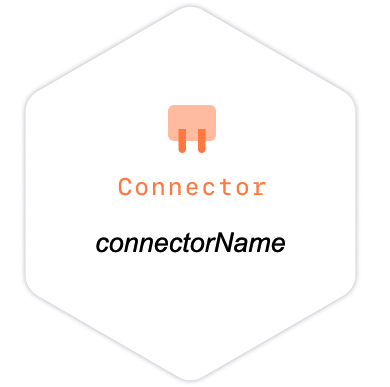

メニューから Connectors を選択し、Datagen Source Connector を選択します。

Connect Datagen Source Connector を追加し、以下の設定でサンプルデータを

stocksトピックに生成します。- Name:

StockSourceConnector - Which topic do you want to send data to?:

stocks - Output message format:

AVRO - Quickstart:

STOCK_TRADES - Max interval between messages:

1000 - Number of tasks for this connector:

1

この "クラスター" の API キーとシークレットも生成して保存する必要があります(まだ行っていない場合)。

- Name:

Next をクリックして、コネクターの設定を確認します。次に Launch をクリックして、ターゲットトピックへのデータの送信を開始します。

コネクターは最初は Provisioning と表示されますが、完全に起動すると Running に変わります。

ksqlDB アプリを作成する¶

- ksqlDB に移動します。

- Create application myself をクリックします。

- Global access を選択し、Continue をクリックします。

- アプリケーション名(

ksqlDB_stocks_appなど)を指定し、ストリーミングユニット数のデフォルトを受け入れます。 - Launch application をクリックします。

ちなみに

- プロビジョニングには多少の時間がかかります。1 時間ほどかかる場合もあります。

- "グローバル" アクセスで ksqlDB アプリを作成すると、アプリ自体の個別の ACL を作成する必要がなくなります。グローバルアクセスの場合、Kafka に対する ksqlDB クラスターのアクセス権は、ksqlDB をプロビジョニングしたユーザーのアクセス権と同じレベルになります。ksqlDB クラスターでアクセス権をきめ細かく設定した ACL を管理する方法の詳細については、「付録 A: アクセス権をきめ細かく設定した ksqlDB アプリの作成と ACL の割り当て」を参照してください。

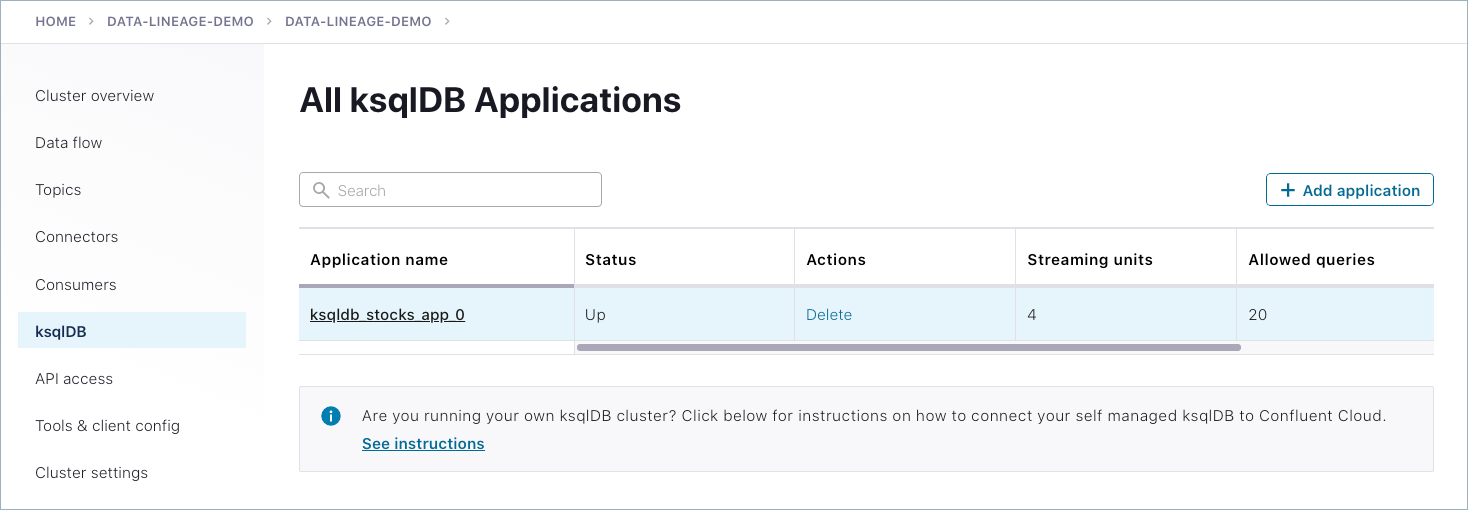

ksqlDB アプリが実行されていることを確認する¶

Cloud Console の ksqlDB アプリのリストに戻ります。

ksqlDB アプリではプロビジョニングが完了し、状態が Up に変わっているはずです。

株価を条件にしてフィルタリングした永続的なストリームを ksqlDB で作成する¶

ksqlDB の Editor に移動し、ksqlDB アプリ ksqlDB_stocks_app をクリックして開き(ksqlDB_stocks_app > Editor)、以下の永続的なストリームを作成します。

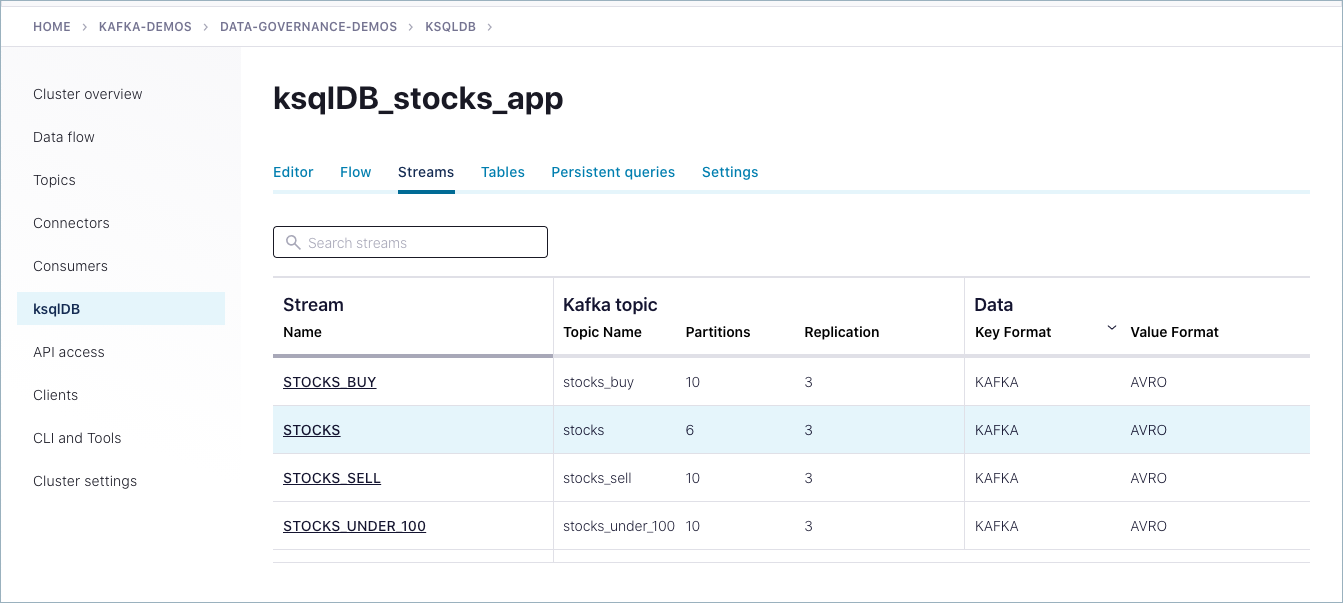

Editor で各クエリステートメントを指定し、Run query をクリックしてクエリを開始します。Streams タブをクリックすると、実行中のクエリのリストが表示されます。

stocksトピックのストリームを作成し、株価が 100 以下という条件でフィルタリングする永続的なストリームを作成します。このストリームは、stocks_under_100トピックに結果を書き出します。この手順では 3 つの別個のクエリを指定して実行する必要があります。まず

stocksというストリームを作成してから、$100 以下の株価を検索してリスト表示するフィルターを追加します。各クエリの作成後に Run query をクリックし、その後で、次のステートメントを指定するためにエディターをクリアしてください。CREATE STREAM stocks WITH (KAFKA_TOPIC = 'stocks', VALUE_FORMAT = 'AVRO');

CREATE STREAM stocks_under_100 WITH (KAFKA_TOPIC='stocks_under_100', PARTITIONS=10, REPLICAS=3) AS SELECT * FROM stocks WHERE (price <= 100);

SELECT * FROM stocks_under_100 EMIT CHANGES;これらのクエリが実行中の状態になったら、Streams タブをクリックします。2 つの新しいストリーム(

STOCKSとSTOCKS_UNDER_100)が作成されます。(最後のステートメントは、データを UI に出力するためにSTOCKS_UNDER_100ストリームに対して実行する一時クエリです。)購入する株を条件としてフィルタリングする永続的なストリームを作成し、

stocks_buyトピックに結果を書き出します。この手順では、2 つの別個のクエリを指定して実行する必要があります。各クエリの作成後に Run query をクリックし、その後で、次のステートメントを指定するためにエディターをクリアしてください。

CREATE STREAM stocks_buy WITH (KAFKA_TOPIC='stocks_buy', PARTITIONS=10, REPLICAS=3) AS SELECT * FROM stocks WHERE side='BUY';

SELECT * FROM stocks_buy EMIT CHANGES;売却する株を条件としてフィルタリングした永続的なストリームを作成します。

この手順では、2 つの別個のクエリを指定して実行する必要があります。各クエリの作成後に Run query をクリックし、その後で、次のステートメントを指定するためにエディターをクリアしてください。

CREATE STREAM stocks_sell WITH (KAFKA_TOPIC='stocks_sell', PARTITIONS=10, REPLICAS=3) AS SELECT * FROM stocks WHERE side='SELL';

SELECT * FROM stocks_sell EMIT CHANGES;

この手順が完了したら、ksqlDB の Streams タブをクリックします。4 つの永続的な ksqlDB クエリストリームが作成されます。

STOCKSSTOCKS_BUYSTOCKS_SELLSTOCKS_UNDER_100

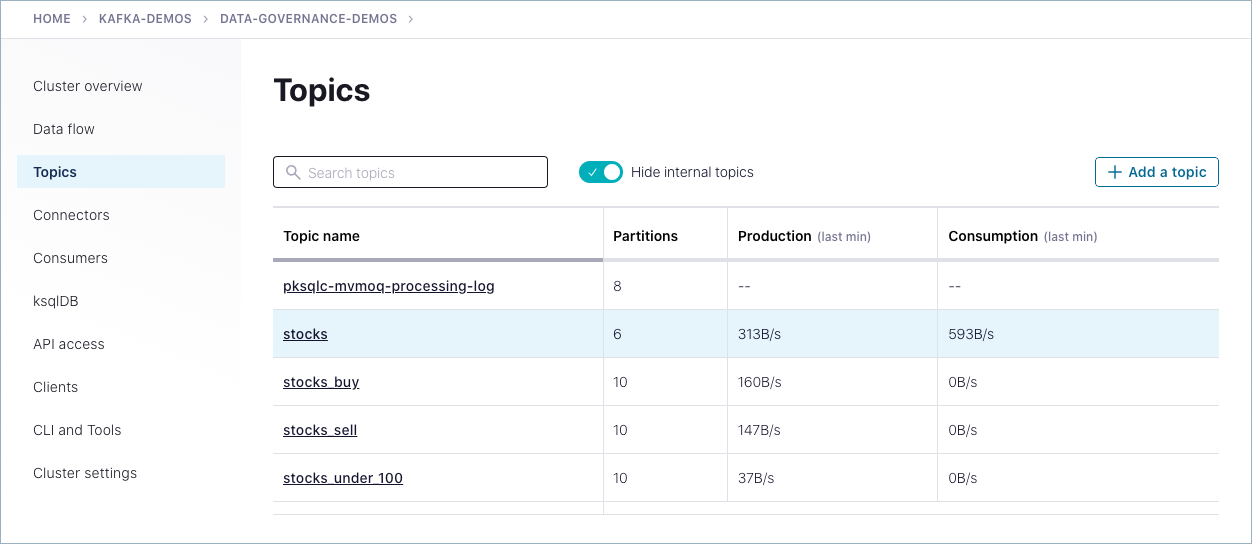

これらのストリームに関連するトピックとスキーマが、対応する各ページにリスト表示されます。

"stocks" トピックからイベントを消費する¶

次は、Confluent Cloud CLI を使用して、stocks トピックからイベントを消費するコンシューマーをセットアップします。

Confluent Cloud CLI にログオンします。(プロンプトでユーザー名とパスワードを入力してください。):

confluent login --url https://confluent.cloud

環境をリスト表示して、対象の環境に現在いることを確認します。

ccloud environment list

必要な場合は、このデモで使用してきた環境を再び選択します。

ccloud environment use <ENVIRONMENT_ID>

クラスターをリスト表示して、正しいクラスターに現在いることを確認します。

ccloud kafka cluster list

必要な場合は、このデモで使用してきたクラスターを再び選択します。

ccloud kafka cluster use <KAFKA_CLUSTER_ID>

コンシューマーの Kafka API 認証情報を作成します。

API キーを作成します。

ccloud api-key create --resource <KAFKA_CLUSTER_ID>

API キーを使用します。

ccloud api-key use <API_KEY> --resource <KAFKA_CLUSTER_ID>

また、キーを保管することもできます。

ccloud api-key store --resource <KAFKA_CLUSTER_ID>

CLI コンシューマーを実行します。

ccloud kafka topic consume stocks_buy --value-format avro --group buy_group

画面の指示に従って、最初の手順で生成した スキーマレジストリ API キーを指定します。

コンシューマーのデータがコンシューマーに生成されていることがコマンドラインに表示されます。以下に例を示します。

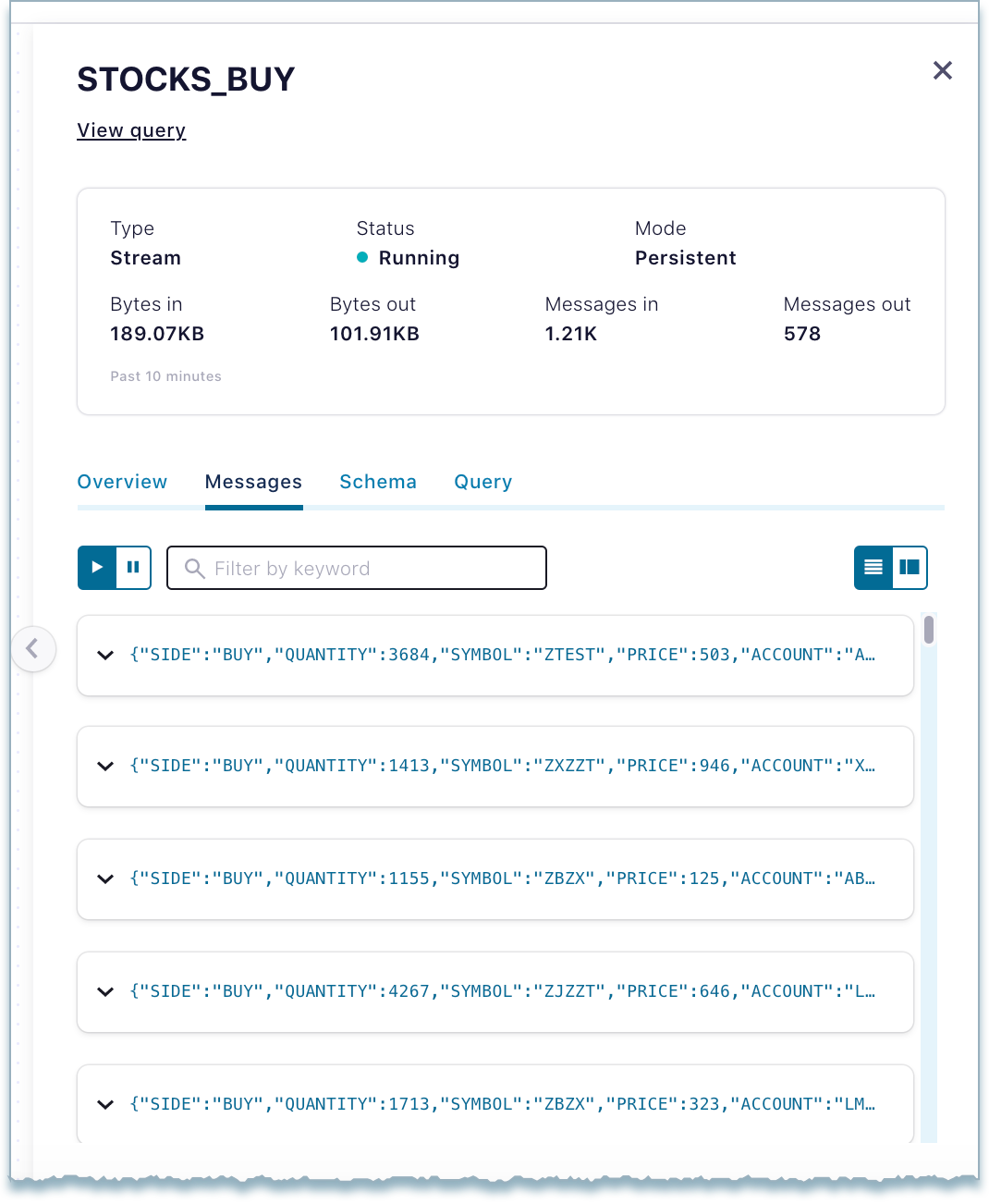

Vickys-MacBook-Pro:~ vicky$ ccloud kafka topic consume stocks_buy --value-format avro --group buy_group Enter your Schema Registry API key: ***************** Enter your Schema Registry API secret: **************************************************************** Starting Kafka Consumer. ^C or ^D to exit {"SIDE":{"string":"BUY"},"QUANTITY":{"int":959},"SYMBOL":{"string":"ZVZZT"},"PRICE":{"int":704},"ACCOUNT":{"string":"XYZ789"},"USERID":{"string":"User_8"}} {"ACCOUNT":{"string":"ABC123"},"USERID":{"string":"User_1"},"SIDE":{"string":"BUY"},"QUANTITY":{"int":1838},"SYMBOL":{"string":"ZWZZT"},"PRICE":{"int":405}} {"QUANTITY":{"int":2163},"SYMBOL":{"string":"ZTEST"},"PRICE":{"int":78},"ACCOUNT":{"string":"ABC123"},"USERID":{"string":"User_8"},"SIDE":{"string":"BUY"}} {"PRICE":{"int":165},"ACCOUNT":{"string":"LMN456"},"USERID":{"string":"User_2"},"SIDE":{"string":"BUY"},"QUANTITY":{"int":4675},"SYMBOL":{"string":"ZJZZT"}} {"QUANTITY":{"int":1702},"SYMBOL":{"string":"ZJZZT"},"PRICE":{"int":82},"ACCOUNT":{"string":"XYZ789"},"USERID":{"string":"User_7"},"SIDE":{"string":"BUY"}} {"ACCOUNT":{"string":"LMN456"},"USERID":{"string":"User_9"},"SIDE":{"string":"BUY"},"QUANTITY":{"int":2982},"SYMBOL":{"string":"ZVV"},"PRICE":{"int":643}} {"SIDE":{"string":"BUY"},"QUANTITY":{"int":3687},"SYMBOL":{"string":"ZJZZT"},"PRICE":{"int":514},"ACCOUNT":{"string":"ABC123"},"USERID":{"string":"User_5"}} {"USERID":{"string":"User_5"},"SIDE":{"string":"BUY"},"QUANTITY":{"int":289},"SYMBOL":{"string":"ZJZZT"},"PRICE":{"int":465},"ACCOUNT":{"string":"XYZ789"}} ...

ストリーム系列のデータパイプラインを調査する¶

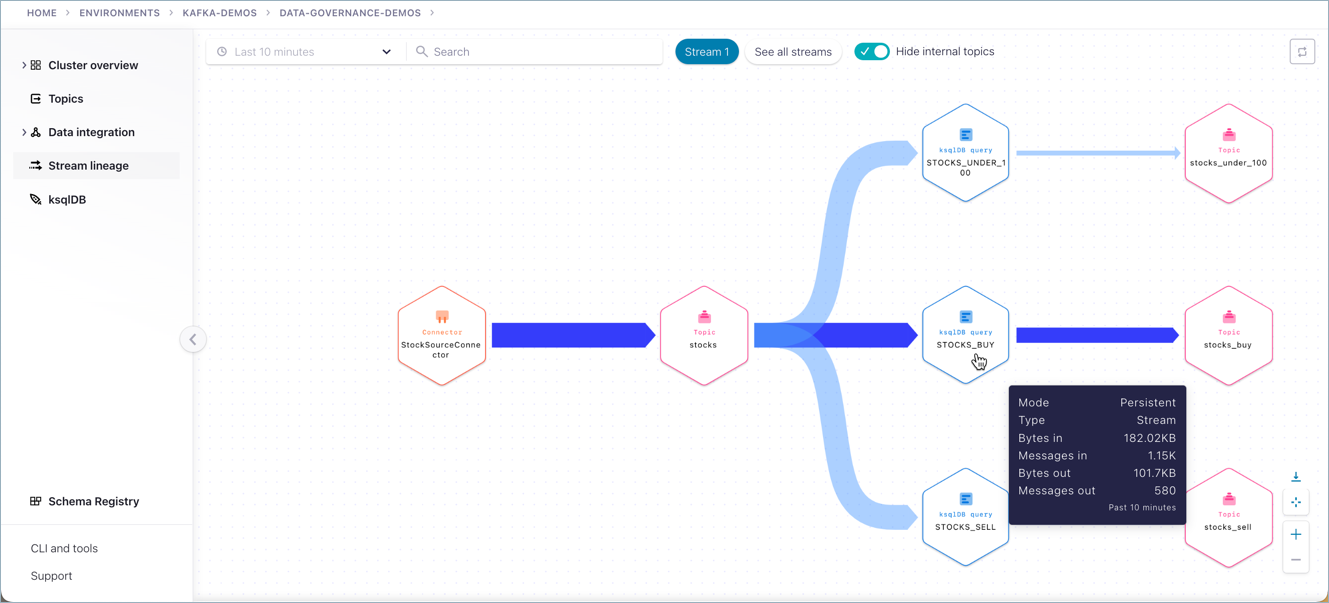

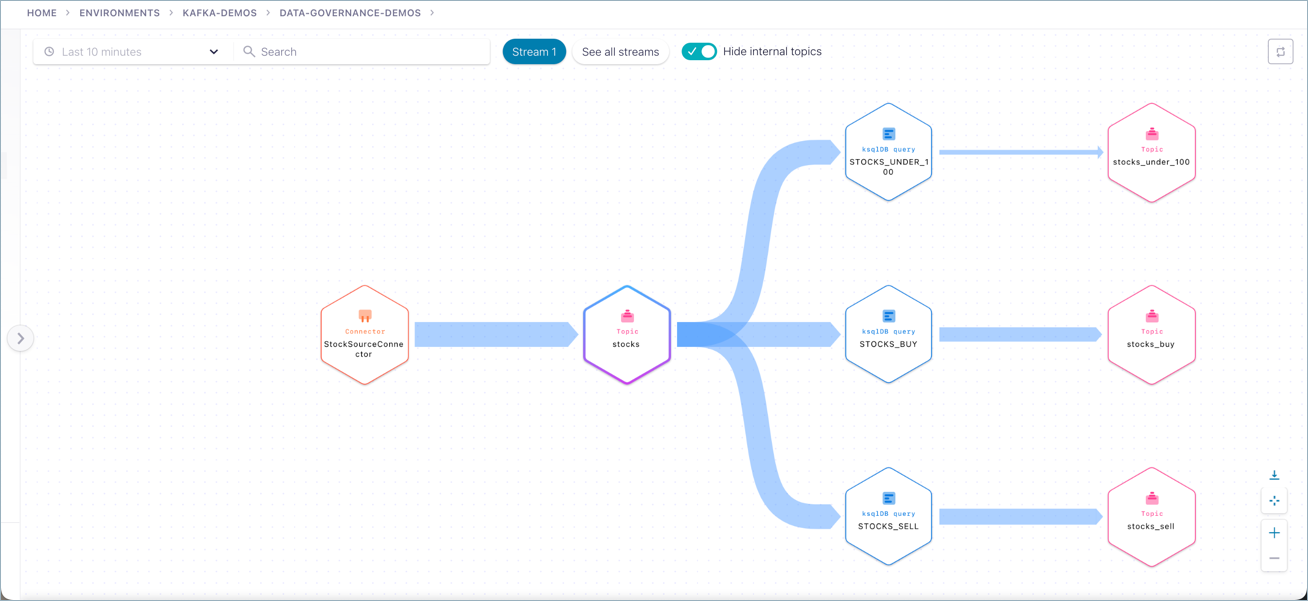

ストリームデータのクイックツアー¶

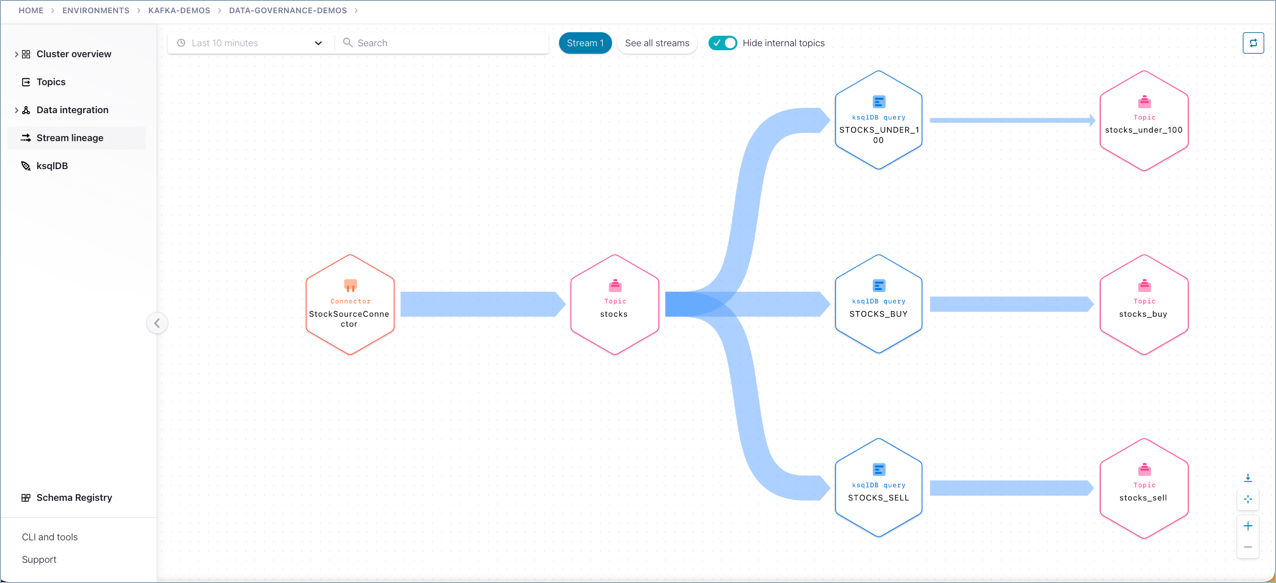

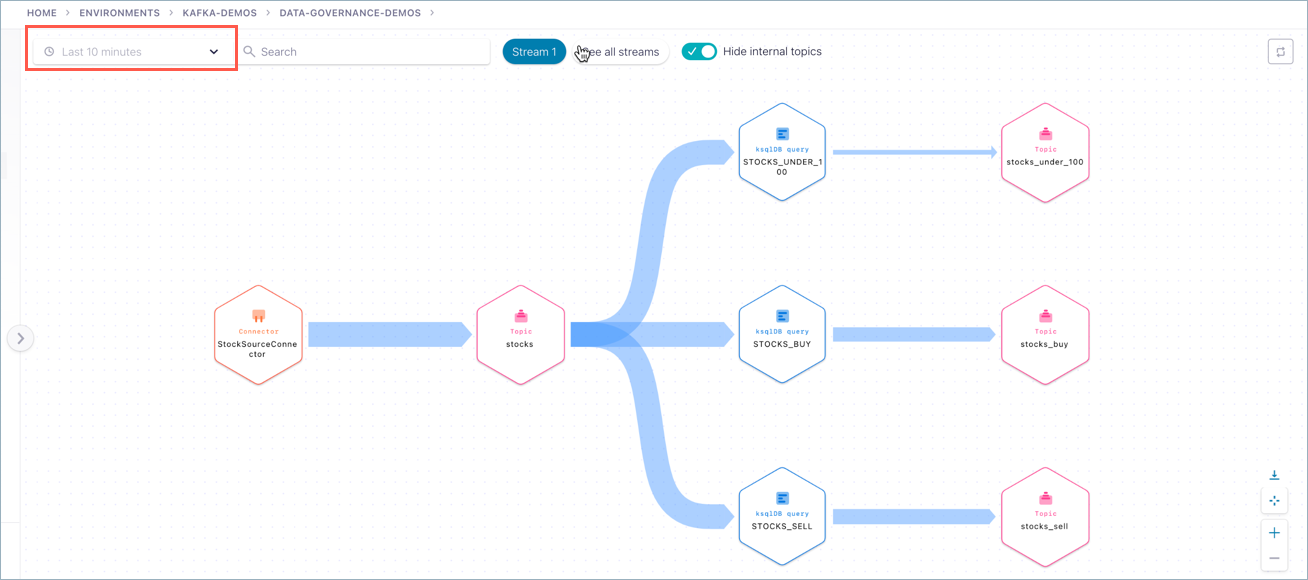

プロデューサーとコンシューマーが実行中の状態になっていれば、ストリーム系列を使用して、ソースコネクターから STOCKS トピックへのデータの流れを視覚化して確認できます。指定の制限値に基づいてデータをフィルタリングするクエリを実行すると、3 つのトピック(STOCKS_BUY、STOCKS_SELL、STOCKS_UNDER_100)にリストが生成されます。

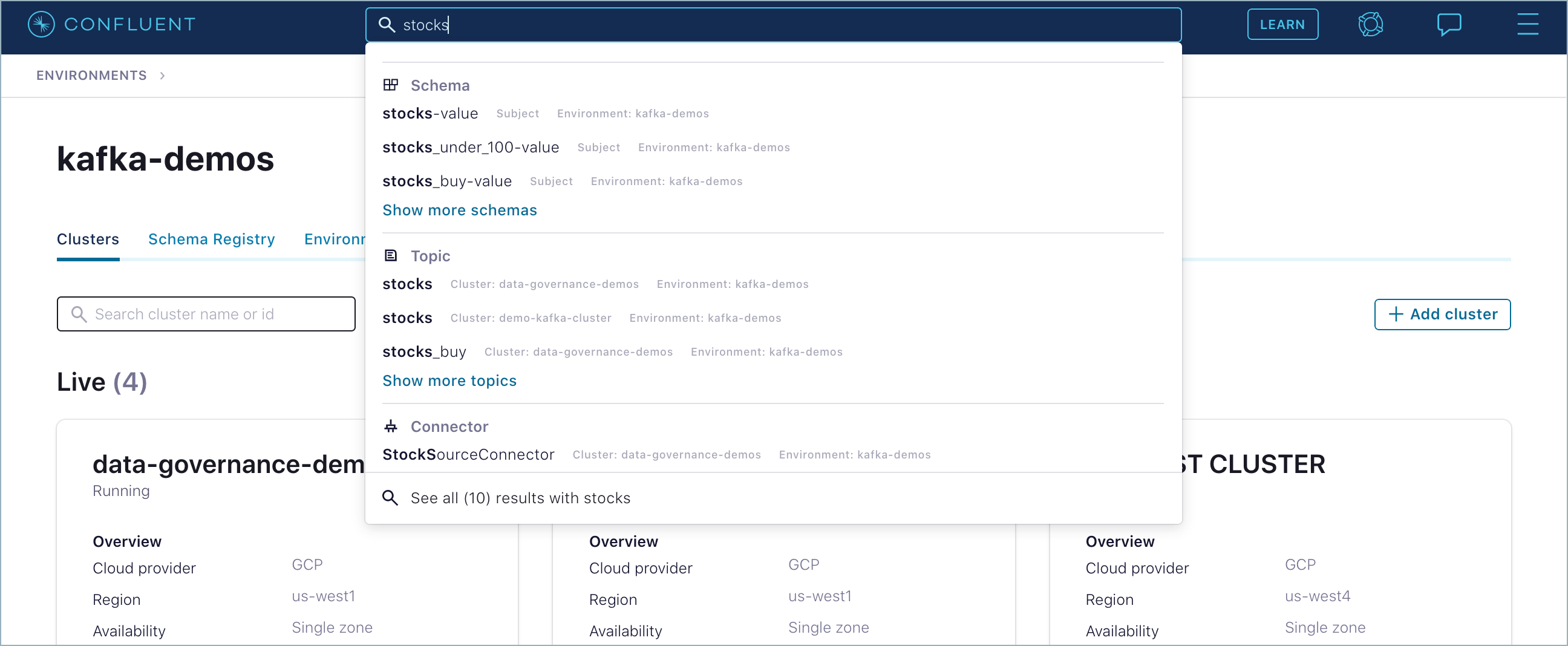

検索ボックスで stocks トピックを検索します。

stocks トピックページの右上にある See in Stream Lineage をクリックします。

stocksのトピックのストリーム系列が表示されます。

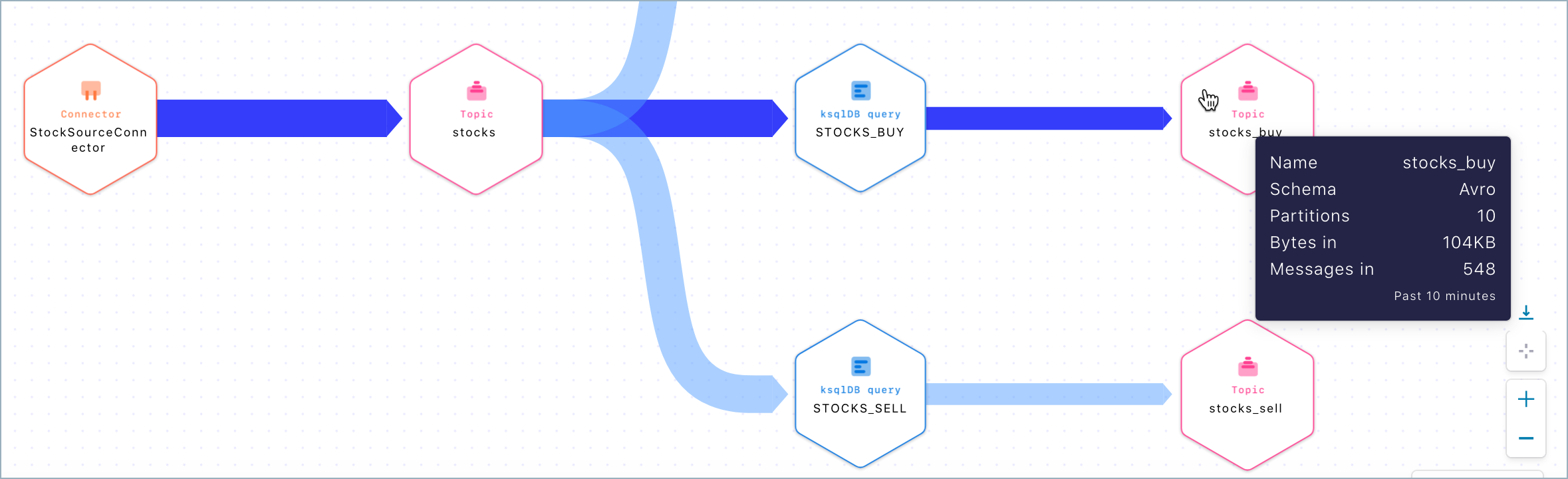

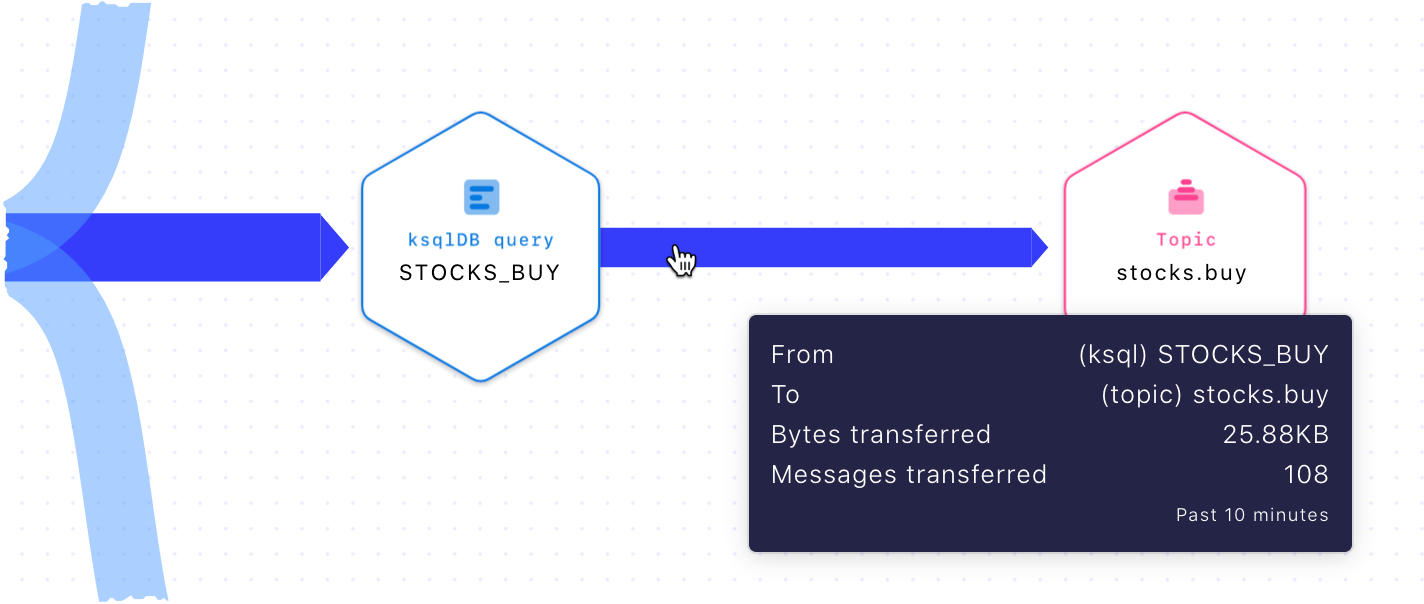

ノードにマウスのカーソルを合わせると、そのデータソースとスループットの概要が表示されます。

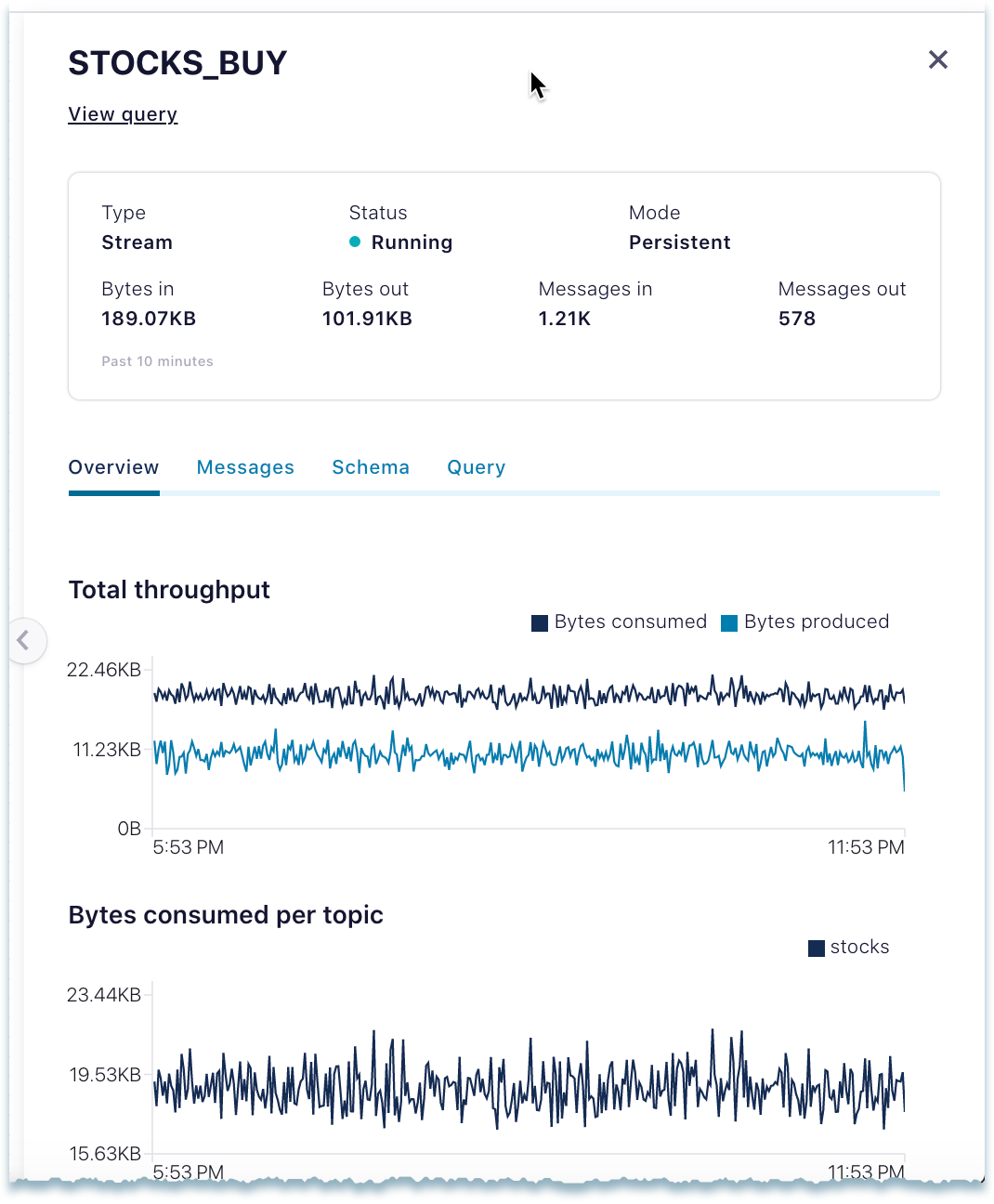

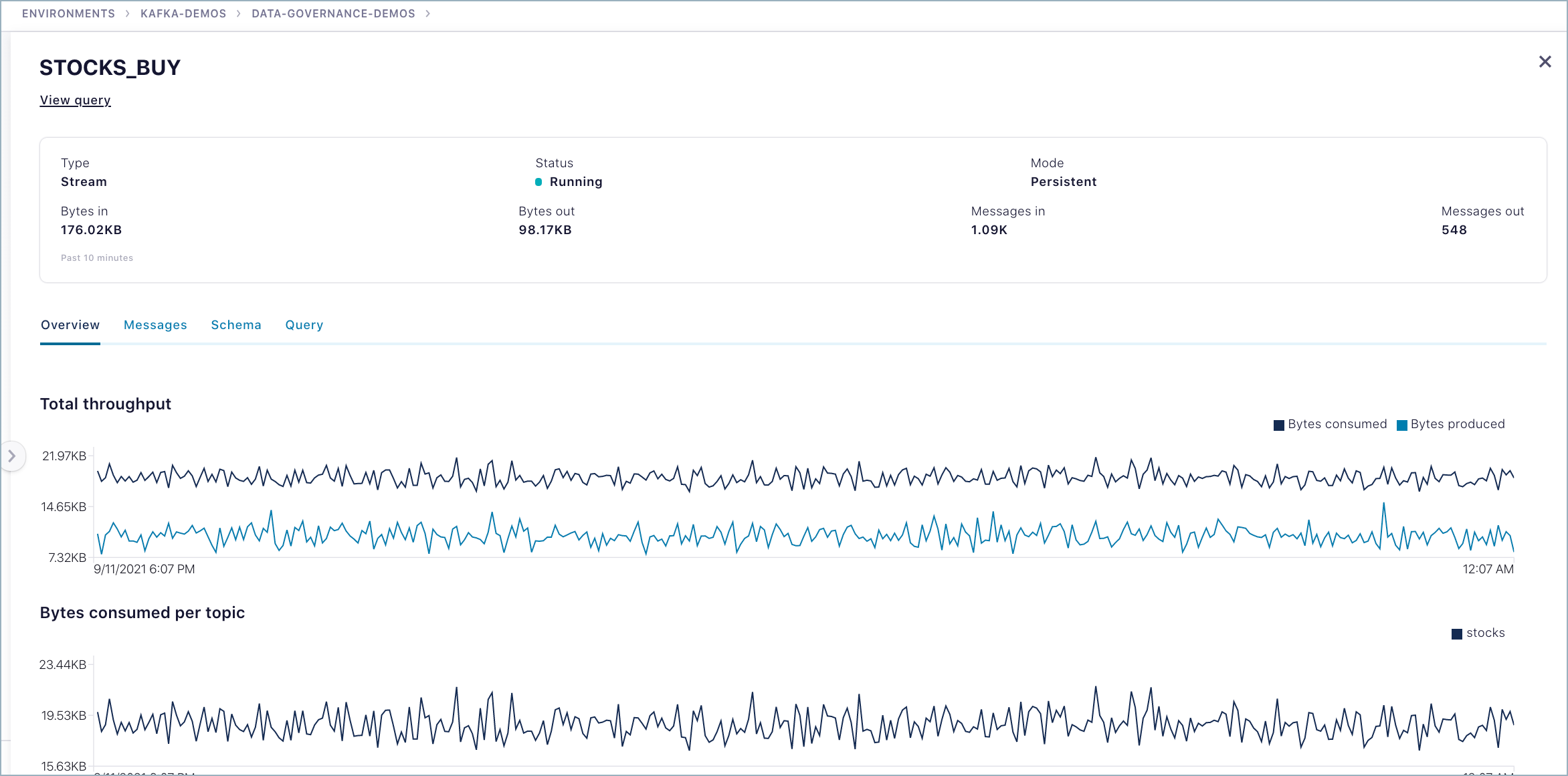

この例では、ksqlDB クエリノードが表示されています。

この場合、サムネイルには以下の情報が表示されます。

- モードとタイプ: 永続的なストリーム

- 直近 10 分間にフローで送受信された合計バイト数

- 直近 10 分間にフローで送受信されたメッセージの合計数

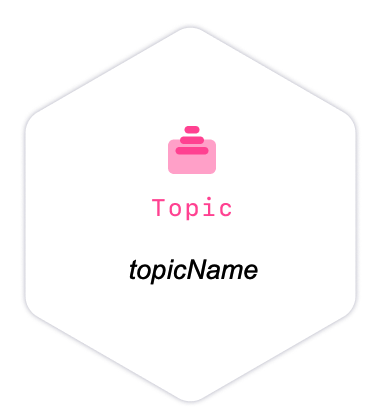

この例では、トピックノードが表示されています。

この場合、サムネイルには以下の情報が表示されます。

- トピック名

- スキーマフォーマット (Avro、Protobuf、または JSON スキーマ)

- このトピックのパーティションの数

- 直近 10 分間にトピックに送信された合計バイト数

- 直近 10 分間にトピックで受信したメッセージの合計数

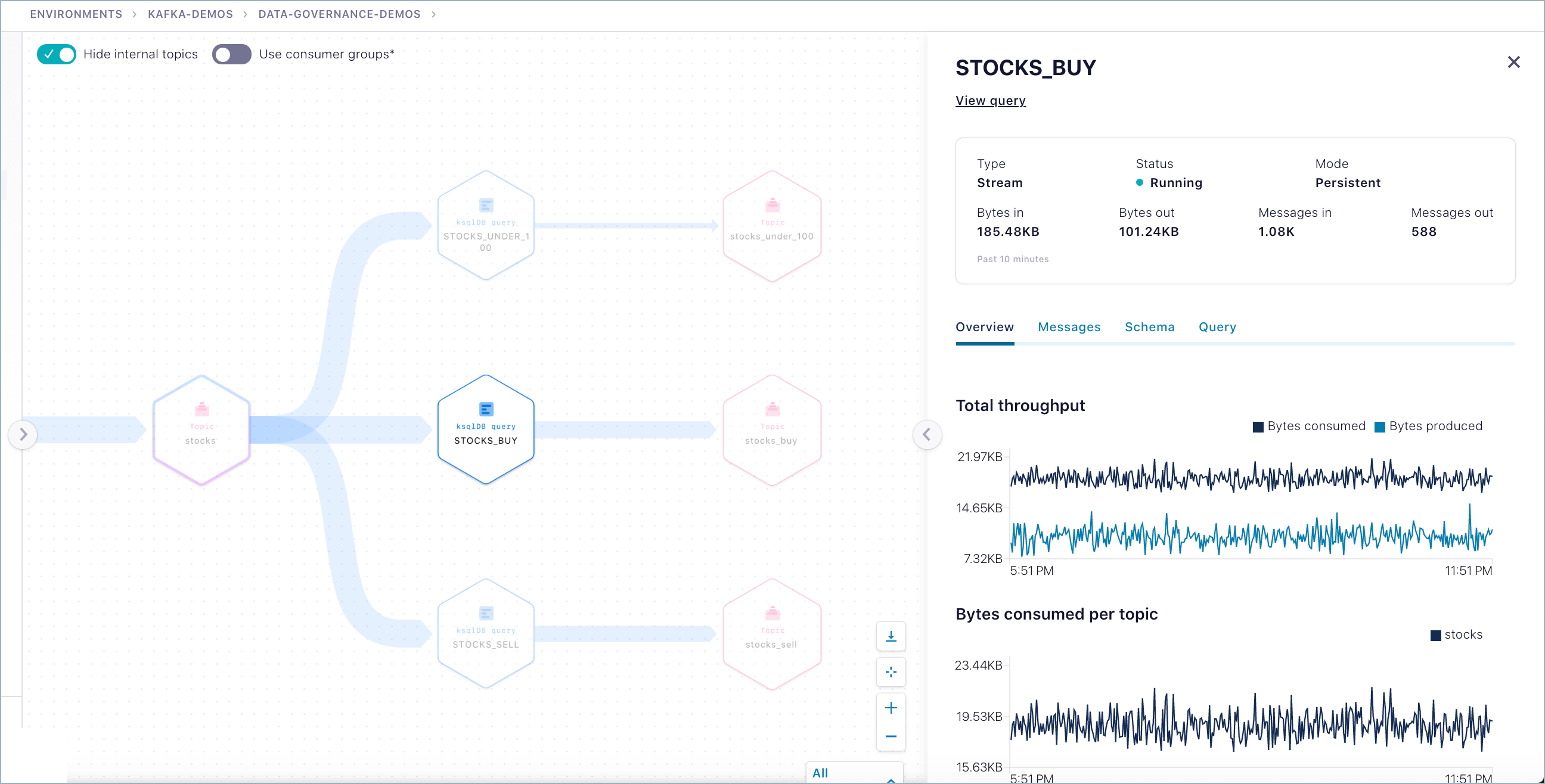

確認するノードをクリックします。

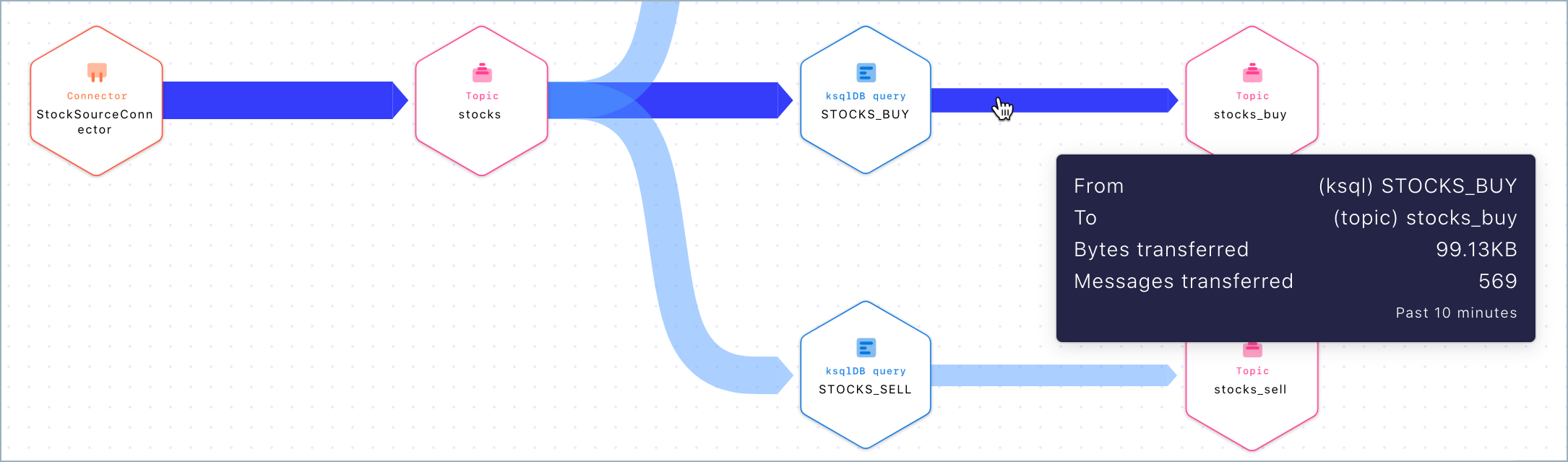

図に戻り、エッジにマウスカーソルを合わせると、対象のノード間のフローの説明が表示されます。

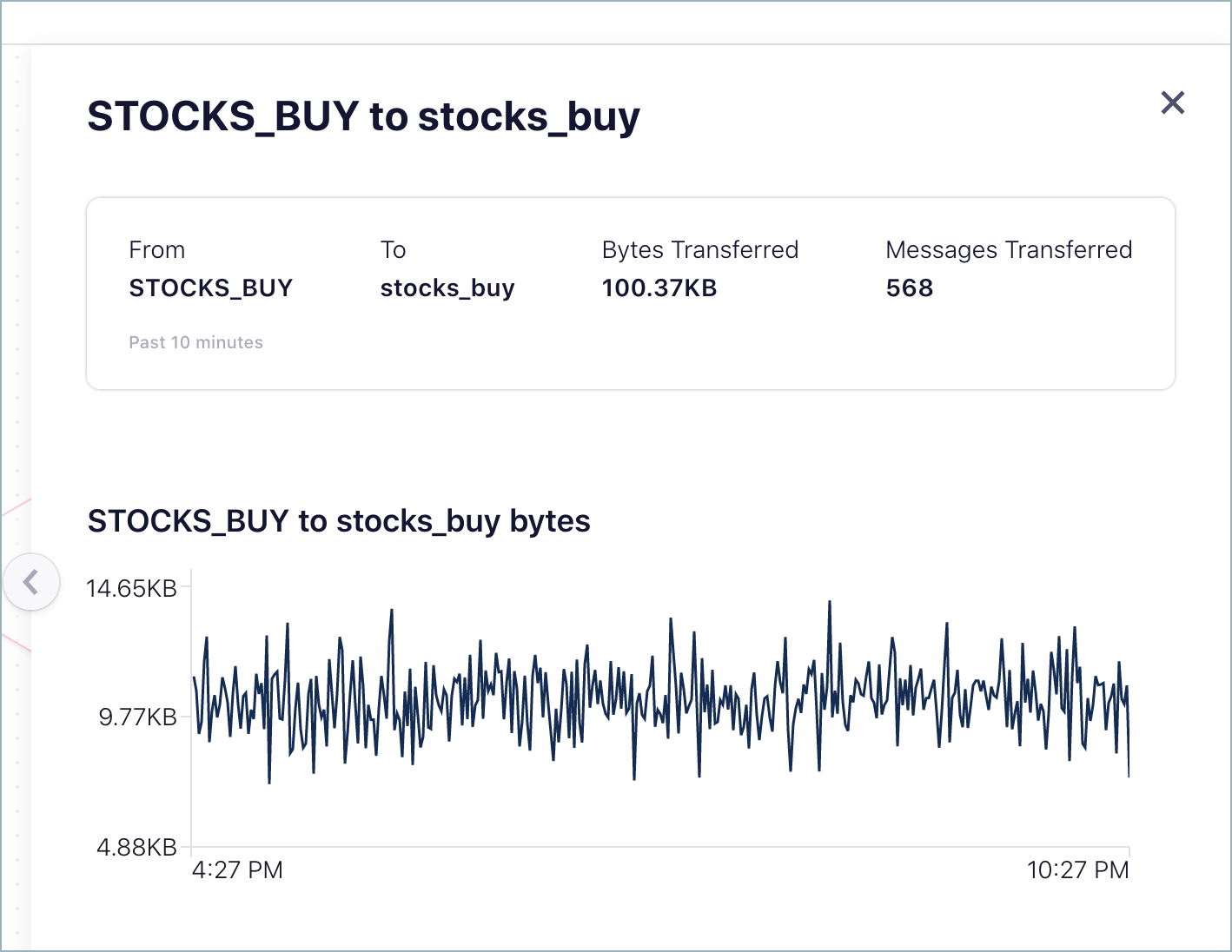

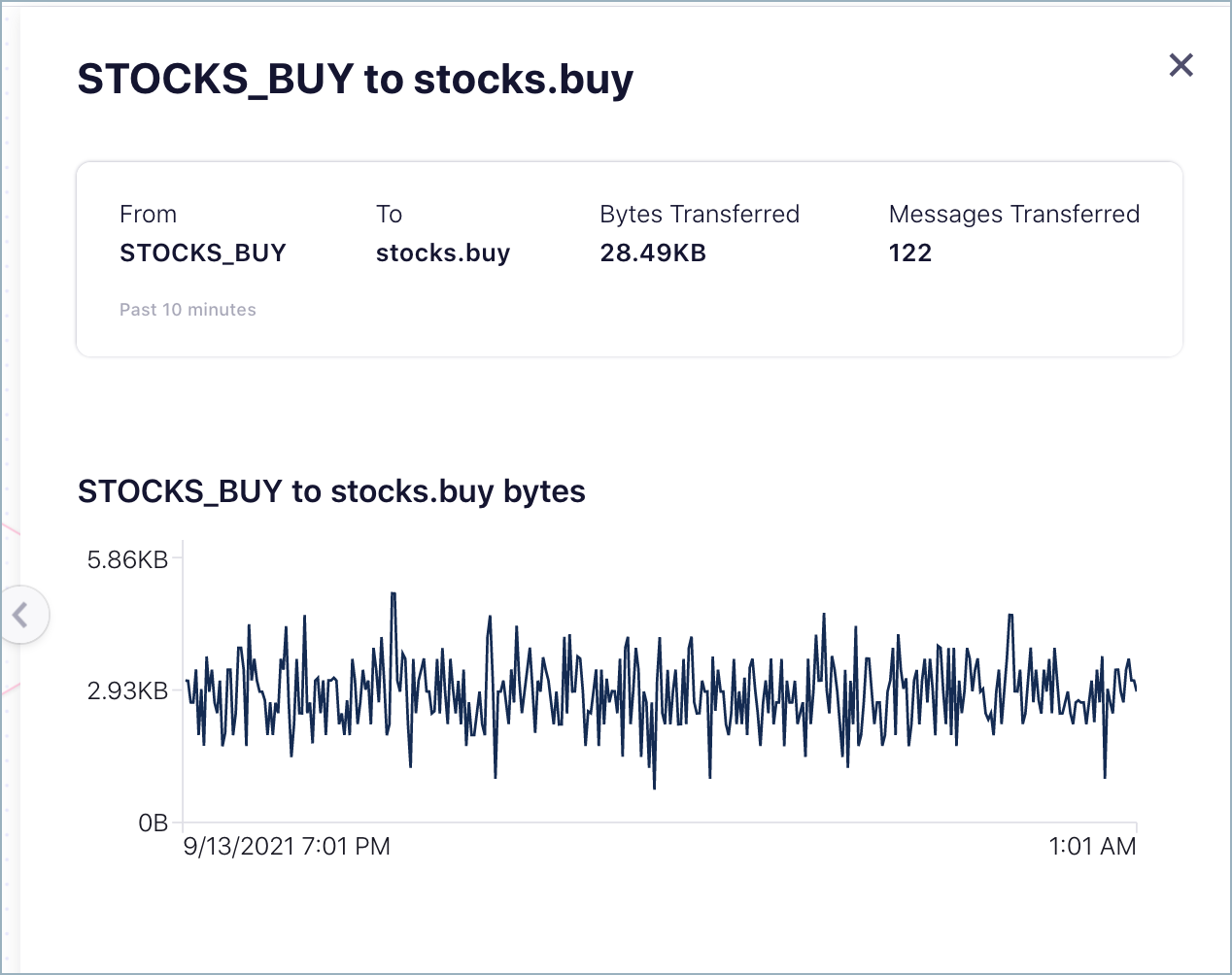

確認するエッジをクリックします。

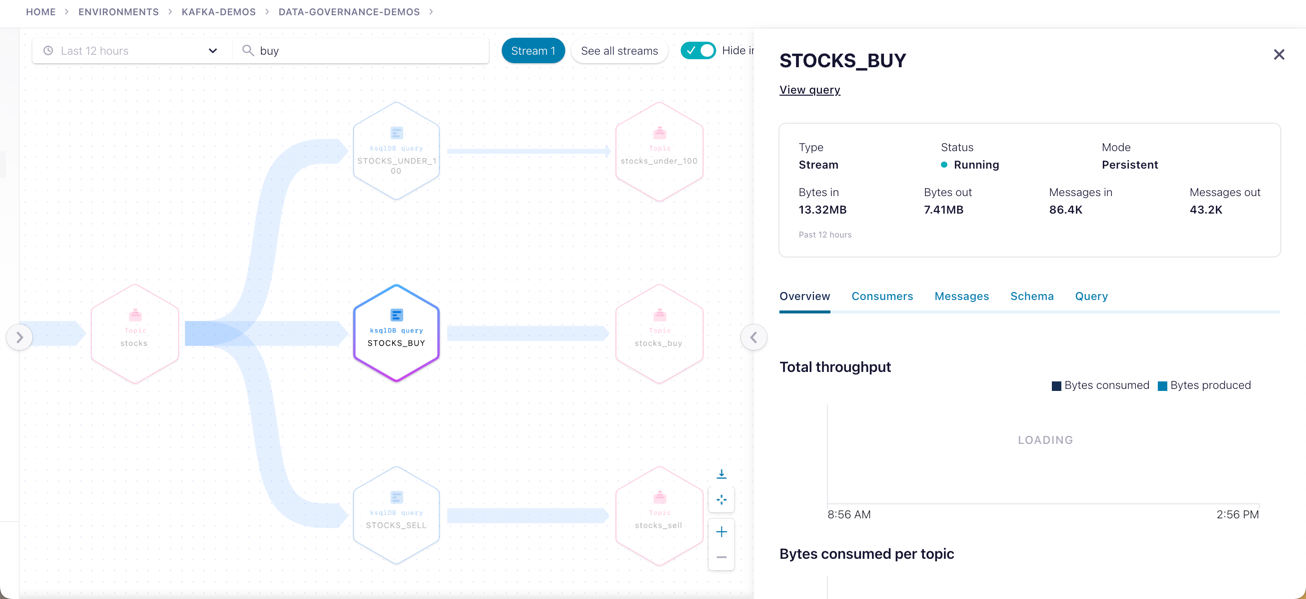

クエリについて確認するためのノードのドリルダウンのタブ¶

ストリーム系列の確認パネルでは、選択したノードに応じて、クエリに関する詳細情報とメトリクスが表示されます。使用できるタブや表示される詳細情報は、クエリによって異なります。以下に例を示します。

Overview タブ - トピックごとのスループットと、消費バイト数および生成バイト数が表示されます。

Messages タブ - トピックで受信したメッセージのリストが表示されます。

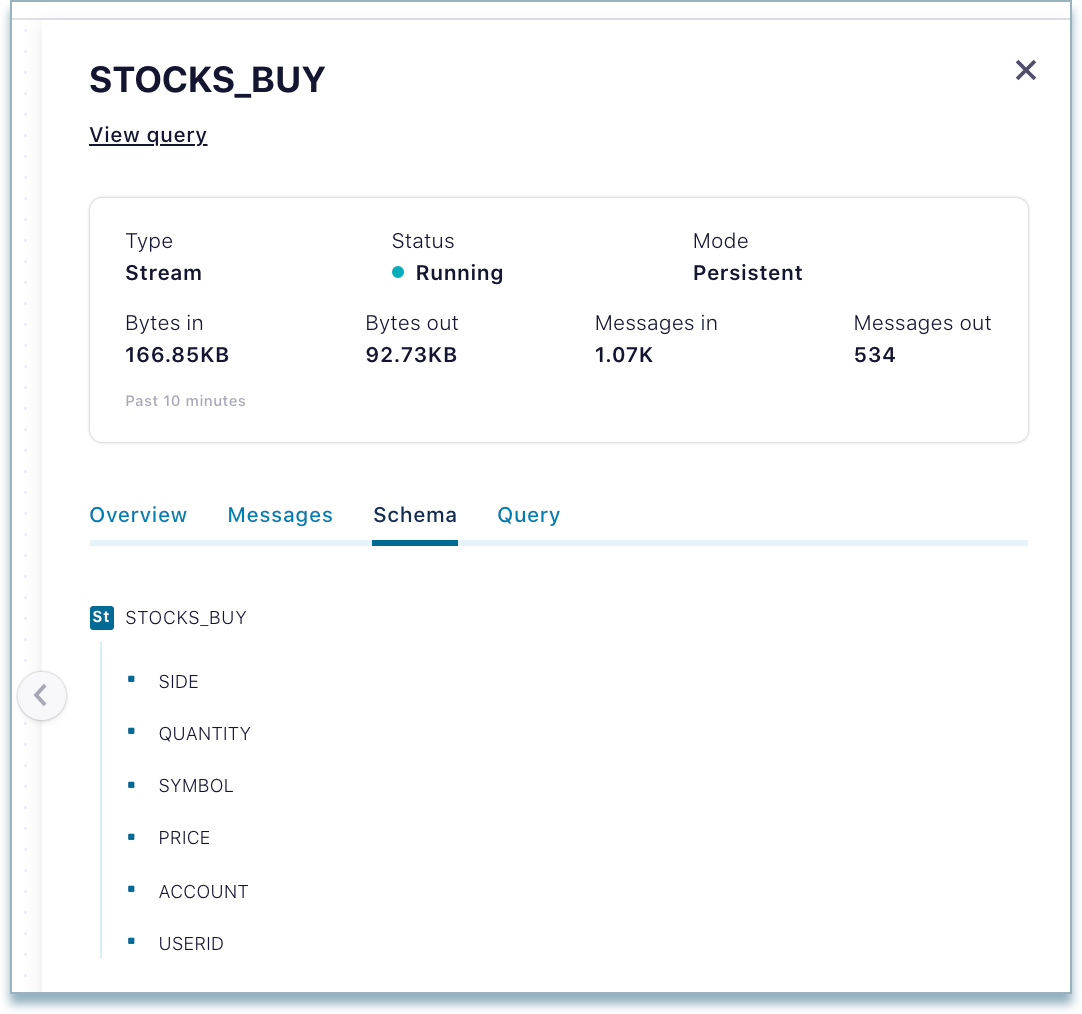

Schema タブ - トピックのスキーマの表示専用のコピーが表示されます。編集可能なバージョンには、トピックから直接アクセスできます(「Confluent Cloud でのスキーマの管理」を参照してください)。

Query タブ - 結果をトピックに送信している永続的なクエリの表示専用のコピーが表示されます。(ストリーム処理の詳細については、「Section 2: Add ksqlDB to the cluster」および「ksqlDB Stream Processing」を参照してください。)

試してみましょう¶

- stocks トピックノードをクリックし、Overview タブでメッセージスループットタイムラインをスクロールしてから、Edit topic をクリックしてそのトピックに移動します。

- stocks_buy トピックノードをクリックし、Schema タブをクリックして関連スキーマを表示します。

- クエリ(stocks_buy クエリなど)をクリックし、Schema タブをクリックします。同じスキーマのメニュースタイルのビューが表示されます。stocks_buy トピックに関連したスキーマは stocks_buy クエリから取り込まれるからです。

- そのことを確認するために、View query をクリックして ksqlDB_stocks_app にリンクしてから、そのアプリの下にある Flow タブをクリックし、その図で stocks_buy をクリックします。(そのクエリの特有のデータフローを ksqlDB アプリから直接視覚化することも可能ですが、ストリーム系列の場合のようにすべてのトピックに対するすべてのクエリのフローをまとめて表示することはできません。)

内部トピックの表示/非表示の切り替え¶

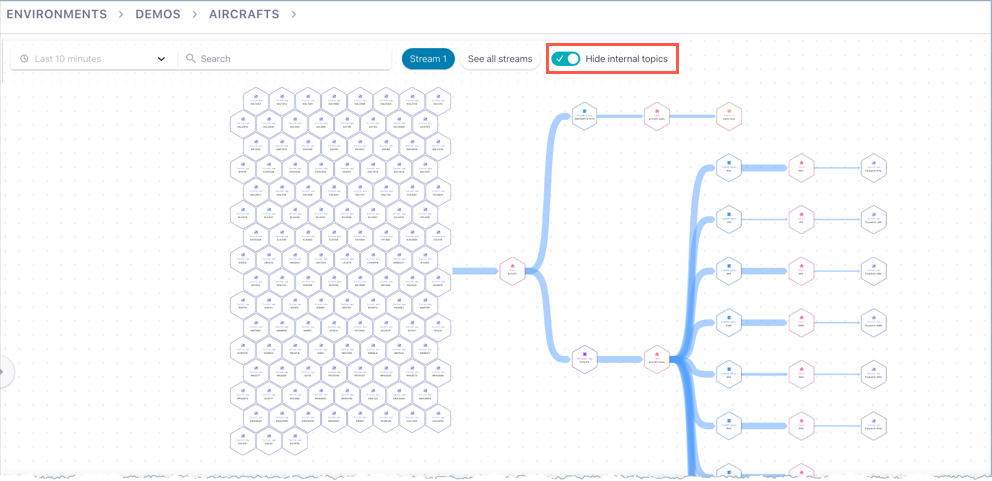

ストリーム系列のグラフビューには、内部(システム)トピックの表示/非表示を切り替えるオプションがあります。システムトピックは、レプリケーション係数、パーティション数などの Confluent Cloud メタデータを管理および追跡するものです。通常は、このシステムメタデータはユーザー独自のトピックに関連するデータよりも関心が低いため、非表示にしておきます。

図の表示のブラウズ¶

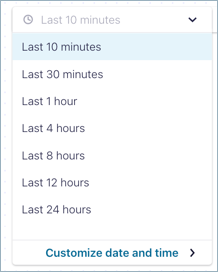

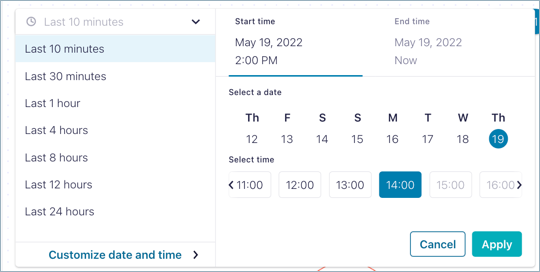

Set the Diagram to a Point in Time¶

重要

This feature is available as a preview feature. A preview feature is a component of Confluent Cloud that is being introduced to gain early feedback. This feature can be used for evaluation and non-production testing purposes or to provide feedback to Confluent. Your comments, questions, and suggestions are encouraged and can be submitted to stream-governance-preview@confluent.io.

By default, graphs represent the last 10 minutes of data flowing through the system. You can navigate and search the graphs in this default time window, or set a specific time window. These settings apply to all data on the cluster, whether that data is currently on-screen or not.

Pre-set windows are available for:

- Last 10 minutes

- Last 30 minutes

- Last 1 hour

- Last 4 hours

- Last 8 hours

- Last 12 hours

- Last 24 hours (maximum size of a pre-set time window)

You can also set a custom date and time window for your search, going back 7 days for a selected 1 hour block.

The graphs, nodes, and available data will change depending on the selected time window. For example, a custom setting to show data only from last Friday from 6:00-7:00 AM will not show streams created later in the week. Similarly, the graph search is dependent on the time window setting, and will not find data that isn't available in the current time window.

Search the Graph¶

重要

This feature is available as a preview feature. A preview feature is a component of Confluent Cloud that is being introduced to gain early feedback. This feature can be used for evaluation and non-production testing purposes or to provide feedback to Confluent. Your comments, questions, and suggestions are encouraged and can be submitted to stream-governance-preview@confluent.io.

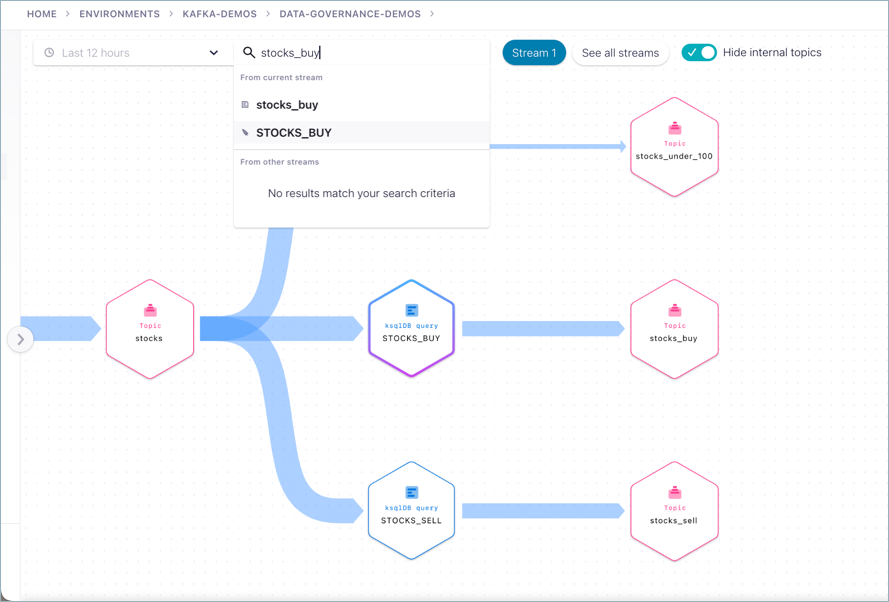

You can search the graph for partial or full names of entities. The search finds topic names, connector names, ksqlDB query names, consumer groups, and producer client IDs. The search spans globally across the cluster, not just on-screen nodes in the current diagram.

Keep in mind that the search applies to data available across the cluster for the selected time window.

To execute a graph search, click into the Search bar and type a name (such as buy in this example).

Next, select a search result by clicking it (for example STOCKS_BUY).

The drilldown for that entity is displayed.

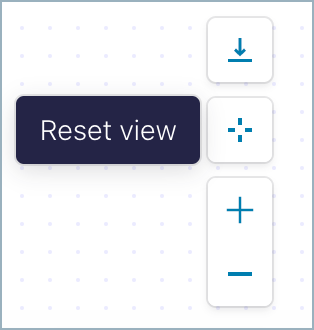

表示のリセット¶

表示をリセットして、図のフォーカスを元の位置(エンティティの中央)に戻すには、ツールパネルの右下にあるリセットアイコン ![]() をクリックします。

をクリックします。

ちなみに

トピック、ksqlDB テーブルまたはストリーム、プロデューサー、コンシューマーなど、1 つのエンティティ内から系列図を開いた場合にのみ ビューのリセット を使用できます。左側のメニューまたはダッシュボードから系列図を開いた場合は、適用されません。その場合は、グローバルなビューとなり、最初に特定のノードが中心となっていないためです。

図の操作¶

図を確認するには、カーソルでクリック、長押し、ドラッグするか、Mac トラックパッドの 3 本指ドラッグなどと同様の操作を行います。

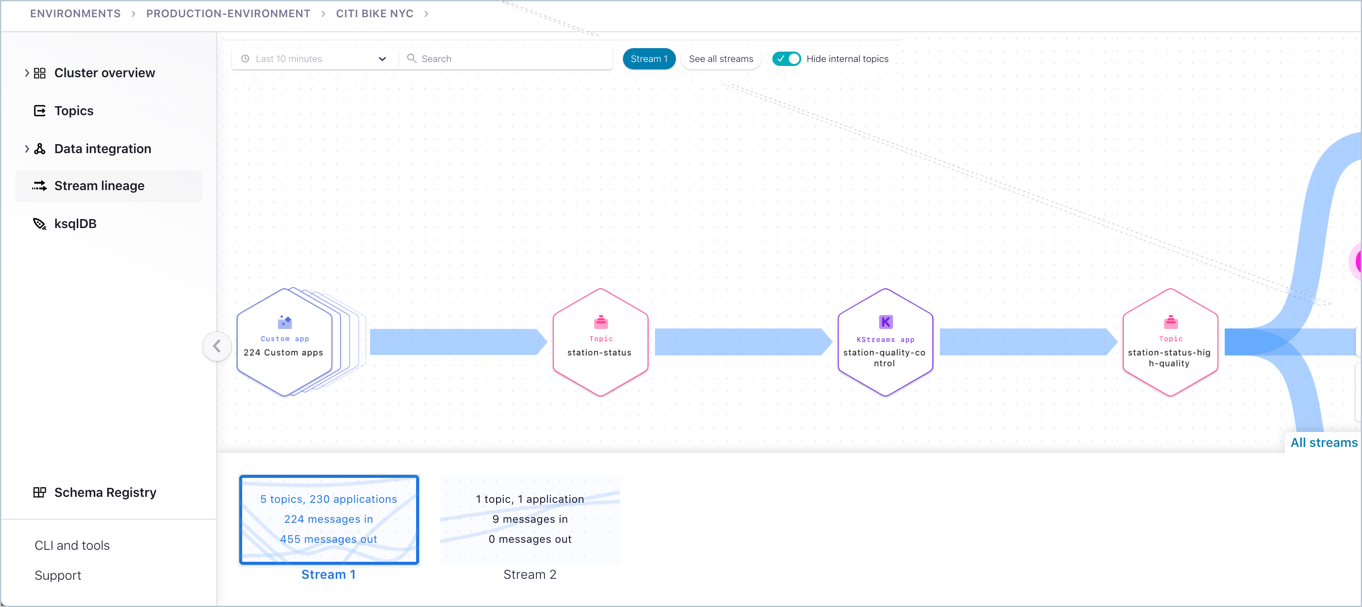

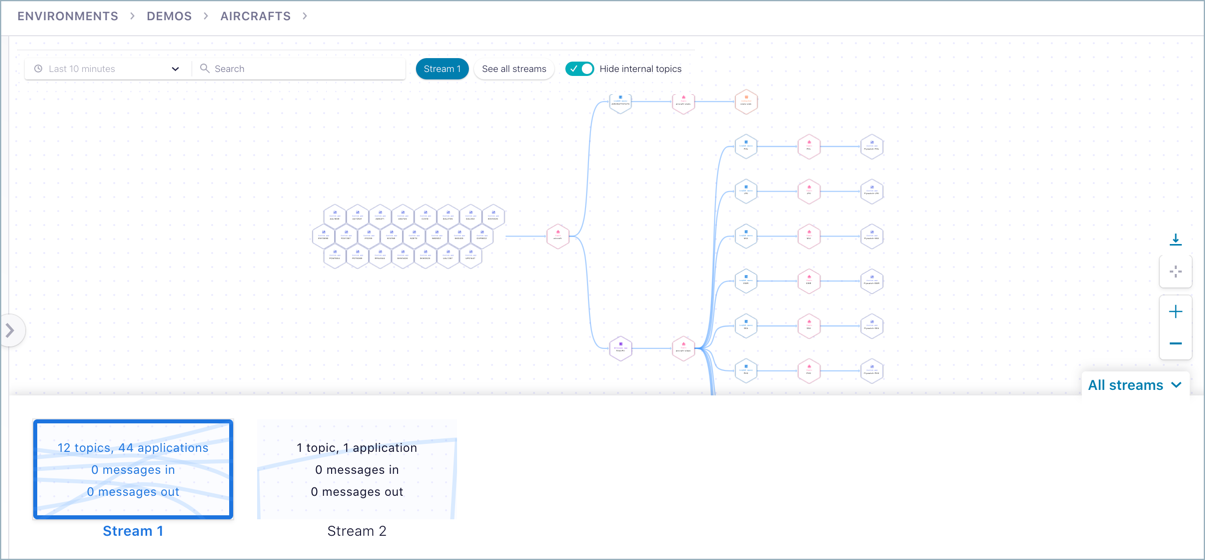

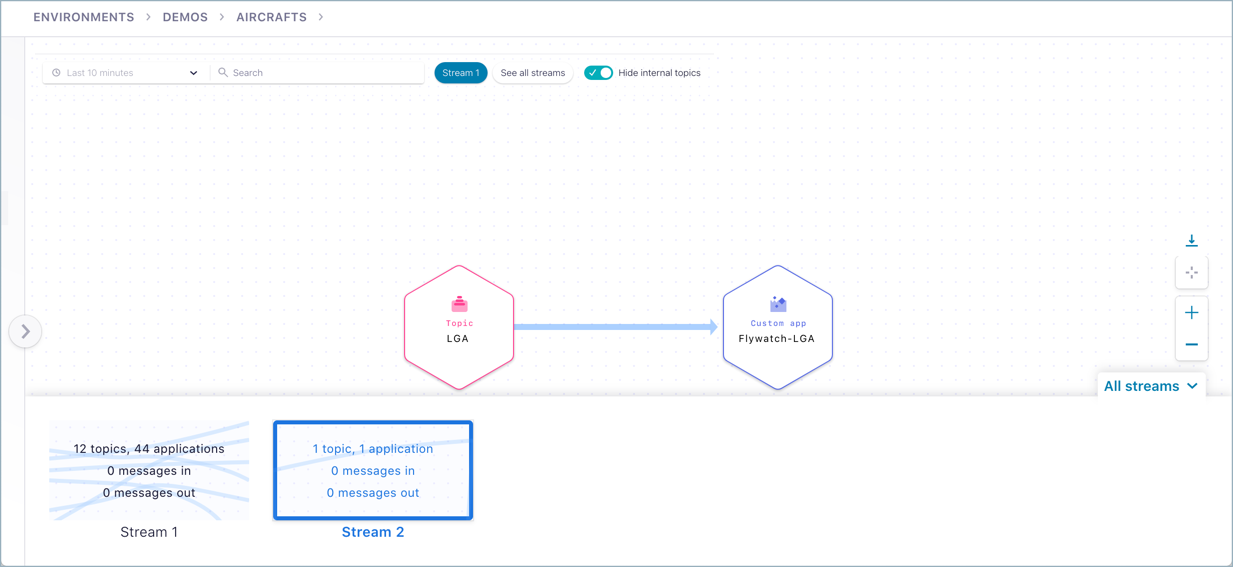

すべてのストリーム¶

図の右下の All Streams をクリックすると、データフローを示すカードが表示されます。

デフォルトのビューでは Stream 1 が表示されます。

別のカードをクリックすると、Stream 2 など、特定のストリームがフォーカスされます。図の表示が更新され、選択されたストリームのみが表示されます。

データノードについて¶

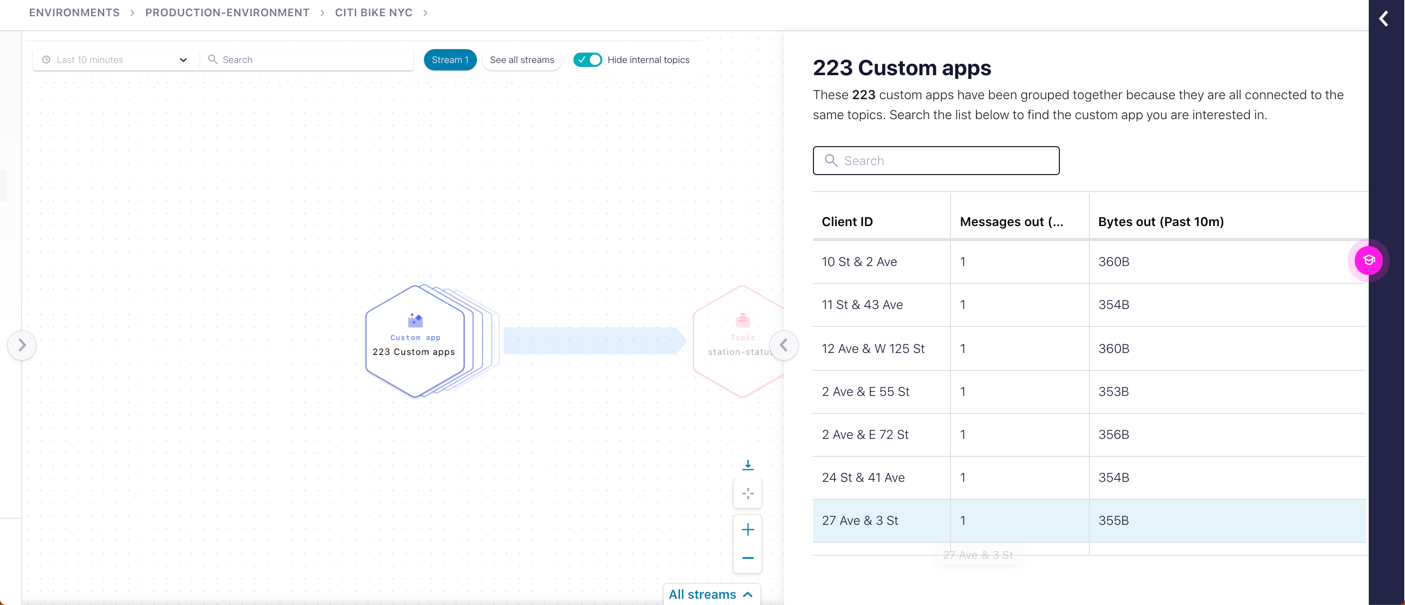

Consumers and producers are automatically grouped; that is, a group of consumers or producers is represented as a single node that expands upon drilldown to show the client IDs.

ノードグループについて¶

ワークフローで同じタイプのノード数がしきい値に達した場合(24 個以上の類似ノード)、画面領域を節約し、操作性を向上させるために、ストリーム系列がこれらのノードを 1 つのノードグループにまとめます。このグループ化の目的は、同じ接続ポイントとデータをやり取りして処理する類似ノードの視認性を高めることにあります。

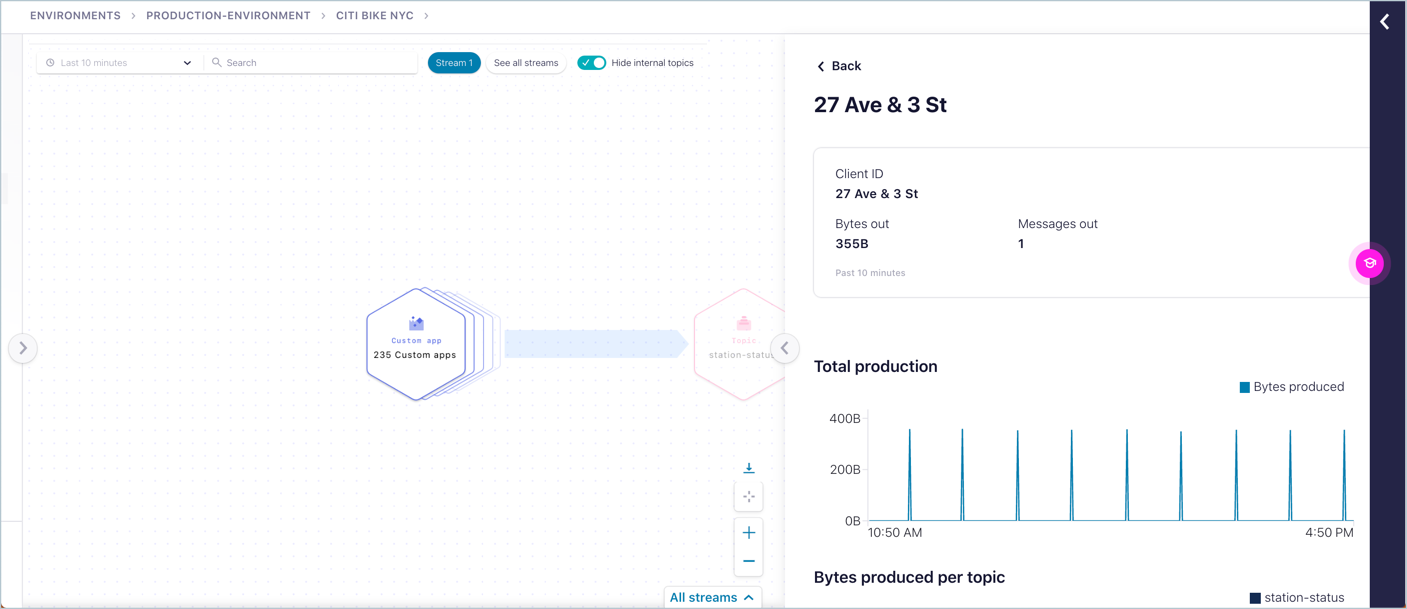

ノードグループに含まれる各ノードの詳細を確認するには、以下の手順を実行します。

複合ノード(ノードグループ)をクリックすると、個々のノードが右側に表示されます。

右側のリストからノードを選択し、そのノードの詳細を確認します。

視認性の向上を目的として類似ノードの自動グループ化はあらゆるノードタイプに適用されますが、類似ノードを多数使用する傾向があるプロデューサーとコンシューマーに適用されることが一般的です。

エッジについて¶

エッジのサムネイルとドリルダウンでは、対象ノード間のフローがわかります。以下の内容が表示されます。

- データの送信元のノード

- データの送信先のノード

- 転送されたバイト数

- 転送されたメッセージ数

エッジにカーソルを合わせると、サムネイルが表示されます。

エッジをドリルダウンすると、タブビューが表示されます。

Access Control (RBAC) for Stream Lineage¶

If Role-Based Access Control (RBAC) is configured on your clusters, you must make sure you have access to the appropriate resources, such as clusters, topics, and features such as stream lineage views. This section provides a summary of roles related to stream lineage access.

The following roles have full access to stream lineage views:

Role View Scope Admin Scope OrganizationAdmin All All EnvironmentAdmin Organization, Support Plan, Users All clusters in the environment, スキーマレジストリ, Networking CloudClusterAdmin Organization, Environment, Support Plan, Users, スキーマレジストリ Specified Cluster, Topics, ksqlDB applications, Connectors, Schema Subjects Operator Organization, Environment, Cluster N/A Developer roles (DeveloperManage, DeveloperRead, and DeveloperWrite) do not have access to stream lineage in and of themselves. To give developers stream lineage access, grant them an additional role from the above table with appropriate scope for need-to-know; such as Operator role at the cluster level.

To learn more, see Confluent Cloud でのロールベースアクセス制御(RBAC)の使用.

付録 A: アクセス権をきめ細かく設定した ksqlDB アプリの作成と ACL の割り当て¶

グローバルアクセスの ksqlDB アプリを作成する代わりに、"きめ細かい" アクセスのアプリを作成し、サービスアカウントを割り当てて、その ksqlDB アプリ専用の ACL を作成することも可能です。ksqlDB クラスターのアクセス権を特定のトピックやアクションに限定するのが望ましい場合もあります。

ksqlDB に移動します。

Create application myself をクリックします。

Granular access を選択し、Continue をクリックします。

Create a service account で以下のようにします。

- Create a new one を選択します(使用するアカウントがまだない場合)。

- 新しいサービスアカウントの名前と説明を入力します(

stocks_trader、ksqlDB_stocks_appなど)。 - ksqlDB アプリの作成時に必要な ACL を追加するためのボックスをオンにします。

stocksトピックへのアクセス権を指定し(既に選択されているはずです)、Continue をクリックします。以下のようにして ksqlDB アプリのための ACL を作成します(既にこのアプリ用に作成してある場合、この手順はスキップしてください)。

Confluent Cloud CLI にログオンします。(プロンプトでユーザー名とパスワードを入力してください。):

confluent login --url https://confluent.cloud

環境をリスト表示して、環境 ID を取得します。

ccloud environment list

このデモで使用してきた環境を選択します。

ccloud environment use <ENVIRONMENT_ID>

クラスターをリスト表示して、正しいクラスター ID を取得します。

ccloud kafka cluster list

このデモで使用してきたクラスターを選択します。

ccloud kafka cluster use <KAFKA_CLUSTER_ID>

ksqlDB アプリをリスト表示して、アプリの ID を取得します。

ccloud ksql app list

以下のコマンドを実行して、サービスアカウント ID を取得します。

ccloud ksql app configure-acls <KSQL_APP_ID> * --cluster <KAFKA_CLUSTER_ID> --dry-run

サービスアカウント ID をコピーします(出力の

User:<SERVICE_ACCOUNT_ID>の後に表示されます)。ksql アプリのすべてのトピックに対して、READ アクセスをサービスアカウント ID に許可します。:

ccloud kafka acl create --allow --service-account <SERVICE_ACCOUNT_ID> --operation READ --topic '*'

ksql アプリのすべてのトピックに対して、WRITE アクセスをサービスアカウント ID に許可します。:

ccloud kafka acl create --allow --service-account <SERVICE_ACCOUNT_ID> --operation WRITE --topic '*'

ksql アプリのすべてのトピックに対して、CREATE アクセスをサービスアカウント ID に許可します。:

ccloud kafka acl create --allow --service-account <SERVICE_ACCOUNT_ID> --operation CREATE --topic '*'