重要

このページの日本語コンテンツは古くなっている可能性があります。最新の英語版コンテンツをご覧になるには、こちらをクリックしてください。

Amazon S3 Sink Connector for Confluent Cloud¶

注釈

Confluent Platform 用のコネクターをローカルにインストールする場合は、「Amazon S3 Sink Connector for Confluent Platform」を参照してください。

Connect Amazon S3 Sink Connector for Confluent Cloud を使用すると、Avro、JSON スキーマ、Protobuf、JSON(スキーマレス)、または Bytes フォーマットの Apache Kafka® トピックのデータを、Avro、Parquet、JSON、または Bytes フォーマットで S3 オブジェクトにエクスポートすることができます。環境によっては、S3 コネクターは、生成した S3 オブジェクトを "厳密に 1 回" のデリバリーセマンティクスでコンシューマーに送達することを保証してデータをエクスポートすることができます。

注釈

Parquet 出力フォーマットは、専用クラスター および スタンダードクラスター でのみ使用できます。

Amazon S3 Sink Connector は、定期的に Kafka のデータをポーリングし、データがあれば S3 にアップロードします。時間ベースのパーティショナーによって、すべての Kafka パーティションのデータがチャンクに分割されます。データの各チャンクは、1 つの S3 オブジェクトとして表されます。キー名には、そのデータチャンクのトピック、Kafka パーティション、開始オフセットがエンコードされます。各データチャンクのサイズは、S3 に書き込まれるレコード件数およびスキーマの互換性によって決まります。

機能¶

Amazon S3 Sink Connector には、以下の機能があります。

Exactly Once Delivery: Records that are exported using a deterministic partitioner are delivered with exactly-once semantics regardless of the eventual consistency of Amazon S3.

スキーマありまたはスキーマなしのデータフォーマット: このコネクターは、Avro、JSON スキーマ、Protobuf、JSON(スキーマレス)、または Bytes フォーマットになっている Kafka トピックの入力データをサポートし、Amazon S3 に Avro、Parquet、JSON、または Bytes フォーマットでデータをエクスポートします。Parquet 出力フォーマットは、専用クラスター および スタンダードクラスター でのみ使用できます。スキーマベースのメッセージフォーマット(Avro など)を使用するには、有効なスキーマが Schema Registry に存在する必要があります。詳細については、「スキーマレジストリ Enabled Environments」を参照してください。

スキーマの進化:

schema.compatibilityはNONEに設定されます。パーティショナー: このコネクターは、Kafka クラスの

TimeStampに基づいたTimeBasedPartitionerクラスをサポートします。時間ベースのパーティショニングの選択肢は、日次または毎時です。スケジュールによるローテーションとローテーション間隔: コネクターは、スケジュールされた一定間隔で、ファイルをクローズしてストレージにアップロードすることができます。詳細については、「スケジュールされたローテーション」を参照してください。

Flush size : デフォルト値は 1000 です。この値は、必要に応じて増やすことができます。Confluent Cloud 専用クラスター を実行する場合は、この値を下げることができます(最小値 1)。専用ではないクラスターの最小値は 1000 です。

どのような状況でレコードがストレージにフラッシュされるかを説明するために、以下に例を示します。

デフォルト設定の 1000 を使用し、トピックには 6 つのパーティションがあります。1000 件を超えるレコードが各パーティションに存在すると、ストレージでのファイルの作成が開始されます。

デフォルト設定の 1000 を使用し、パーティショナーが "Hourly" に設定されています。午後 2 時から午後 3 時までの間に 1 つのパーティションに 500 件のレコードが到達しました。午後 3 時にさらに 5 件のレコードがそのパーティションに到達しました。午後 3 時にストレージには、500 件のレコードが表示されます。

注釈

rotate.schedule.interval.msプロパティとrotate.interval.msプロパティをflush.sizeと一緒に使用して、ストレージにファイルを作成する条件を指定できます。これらのパラメーターが有効になり、最初に満たされた条件に基づいてファイルが保管されます。たとえば、トピックのパーティションが 1 つあるとします。

flush.size=1000とrotate.schedule.interval.ms=600000(10 分)を設定します。12:01 から 12:10 までのこのトピックパーティションに 500 件のレコードが表示されます。12:11 から 12:20 まで、追加の 500 件のレコードが表示されます。それぞれ 500 件のレコードが入った 2 つのファイルがストレージバケットに表示されます。これは、flush.size=1000条件が満たされる前に、10 分のrotate.schedule.interval.ms条件が作動したからです。

Writing Record Keys and Headers: In addition to writing the value files to storage, you can enable the connector to write the associated Kafka record keys and headers to storage as files. To enable writing keys, set the configuration property

store.kafka.keystotrue. To enable writing headers, setstore.kafka.headerstotrue. After enabling these configuration properties, the connector writes keys and headers as additional files. These files use the same name as the associated file that stores the record values, with an extension identifying the part of the record (for example,<filename>.keys.avroand<filename>.headers.avro). Key and header files have a one-to-one mapping to the associated value files.注釈

Consider the following when enabling this feature:

- If you configure the connector to store keys or headers as files and the Kafka record has no key or headers present, the connector writes the record to the DLQ. The record will not be in the stored output in Amazon S3.

- Schema evolution only works for the record values when this feature is enabled. If the record headers and keys have schemas, and records are sent with a different schema from the initial one, the connector stops and the task fails.

Connect 用の Confluent Cloud API の使用に関する詳細とサンプルについては、「Confluent Cloud API for Connect」セクションを参照してください。

制限¶

以下の情報を確認してください。

- コネクターの制限事項については、Amazon S3 Sink Connector の制限事項を参照してください。

- 1 つ以上の Single Message Transforms(SMT)を使用する場合は、「SMT の制限」を参照してください。

- Confluent Cloud Schema Registry を使用する場合は、「スキーマレジストリ Enabled Environments」を参照してください。

S3 の IAM ポリシー¶

S3 バケットにアクセスする AWS ユーザーアカウントには、以下のアクセス許可が必要です。

- ListAllMyBuckets

- ListBucket

- GetBucketLocation

- PutObject

- GetObject

- AbortMultipartUpload

- ListMultipartUploadParts

- ListBucketMultipartUploads

以下の JSON をコピーして、ユーザーアカウントの IAM ポリシーを作成します。<bucket-name> は、実際のバケット名に変更してください。詳細については、『ポリシーを作成して IAM ユーザーにアタッチする』を参照してください。

注釈

これは、バケットポリシーではなくユーザーアカウントの IAM ポリシーです。

{

"Version":"2012-10-17",

"Statement":[

{

"Effect":"Allow",

"Action":[

"s3:ListAllMyBuckets"

],

"Resource":"arn:aws:s3:::*"

},

{

"Effect":"Allow",

"Action":[

"s3:ListBucket",

"s3:GetBucketLocation"

],

"Resource":"arn:aws:s3:::<bucket-name>"

},

{

"Effect":"Allow",

"Action":[

"s3:PutObject",

"s3:GetObject",

"s3:AbortMultipartUpload",

"s3:ListMultipartUploadParts",

"s3:ListBucketMultipartUploads"

],

"Resource":"arn:aws:s3:::<bucket-name>/*"

}

]

}

クイックスタート¶

このクイックスタートを使用して、Confluent Cloud S3 Sink Connector の利用を開始することができます。このクイックスタートでは、コネクターを選択し、S3 バケットにイベントをストリーミングするようにコネクターを構成するための基本的な方法について示します。

- 前提条件

- AWS 上の Confluent Cloud クラスターへのアクセスを許可されていること。

- Confluent CLI がインストールされ、クラスター用に構成されていること。「Confluent CLI のインストール」を参照してください。

- スキーマレジストリ ベースのフォーマット(Avro、JSON_SR(JSON スキーマ)、Protobuf など)を使用するには、Schema Registry を有効にしておく必要があります。詳細については、「スキーマレジストリ Enabled Environments」を参照してください。

- Confluent Cloud クラスターと 同じリージョン にある AWS S3 バケット。

- ネットワークに関する考慮事項については、「Networking and DNS Considerations」を参照してください。静的なエグレス IP を使用する方法については、「静的なエグレス IP アドレス」を参照してください。

- バケットにアクセスするために構成された AWS S3 の IAM ポリシー。

- アクセスキー を構成した AWS アカウント。コネクターを設定するときに、これらのアクセスキーを使用します。

- Kafka クラスターの認証情報。次のいずれかの方法で認証情報を指定できます。

- 既存の サービスアカウント のリソース ID を入力する。

- コネクター用の Confluent Cloud サービスアカウント を作成します。「サービスアカウント」のドキュメントで、必要な ACL エントリを確認してください。一部のコネクターには固有の ACL 要件があります。

- Confluent Cloud の API キーとシークレットを作成する。キーとシークレットを作成するには、confluent api-key create を使用するか、コネクターのセットアップ時に Cloud Console で直接 API キーとシークレットを自動生成します。

- (オプション)メッセージングスキーマ(Apache Avro など)を使用する場合は、クラスター用に Confluent Cloud Schema Registry を有効にしておくこと。「スキーマの操作」を参照してください。

注意

kafka-connect-storage-common を使用してスキーマレコードとスキーマレスレコードをストレージに混在させることはできません。このようにするとランタイム例外が発生します。このコネクターの セルフマネージド型 バージョンを使用する場合は、ログファイル (セルフマネージド型コネクターでのみ使用可能です)を参照すると、この問題が明らかになります。

Confluent Cloud Console の使用¶

ステップ 1: Confluent Cloud クラスターを起動します。¶

インストール手順については、「Quick Start for Confluent Cloud」を参照してください。

ステップ 2: コネクターを追加します。¶

左のナビゲーションメニューの Data integration をクリックし、Connectors をクリックします。クラスター内に既にコネクターがある場合は、+ Add connector をクリックします。

ステップ 4: コネクターの詳細を入力します。¶

注釈

- すべての 前提条件 を満たしていることを確認してください。

- アスタリスク ( * ) は必須項目であることを示しています。

Add Amazon S3 Sink connector 画面で、以下を実行します。

既に Kafka トピックを用意している場合は、Topics リストから接続するトピックを選択します。

新しいトピックを作成するには、+Add new topic をクリックします。

- Kafka Cluster credentials で Kafka クラスターの認証情報の指定方法を選択します。以下のいずれかのオプションを選択できます。

- Global Access: コネクターは、ユーザーがアクセス権限を持つすべての対象にアクセスできます。グローバルアクセスの場合、コネクターのアクセス権限は、ユーザーのアカウントにリンクされます。このオプションは本稼働環境では推奨されません。

- Granular access: コネクターのアクセスが制限されます。コネクターのアクセス権限は サービスアカウント から制御できます。本稼働環境にはこのオプションをお勧めします。

- Use an existing API key: 保存済みの API キーおよびシークレット部分を入力できます。API キーとシークレットを入力するか Cloud Console でこれらを生成することもできます。

- Continue をクリックします。

- Amazon S3 credentials の下の Amazon Access Key ID と Amazon Secret Access Key フィールドに AWS 認証情報を入力します。これらのセットアップ方法については、「プログラムによるアクセス」を参照してください。

- Amazon S3 bucket name セクションに S3 バケット名を入力します。

- Continue をクリックします。

注釈

構成プロパティの値と定義については、「構成プロパティ」を参照してください。

Input Kafka record value で、Kafka 入力レコード値のフォーマット(Kafka トピックから送られるデータ)を AVRO、JSON_SR(JSON スキーマ)、PROTOBUF、JSON(スキーマレス)、または BYTES から選択します。スキーマベースのメッセージフォーマット(Avro、JSON_SR(JSON スキーマ)、Protobuf など)を使用するには、有効なスキーマが Schema Registry に存在する必要があります。

注釈

このコネクターでは、以下の入出力フォーマットはサポートされていません。

- 入力フォーマット JSON から出力フォーマット AVRO

- 入力フォーマット JSON から出力フォーマット PARQUET

Output Kafka record value で、Kafka 出力レコード値のフォーマット(コネクターから送られるデータ)を AVRO、Parquet、JSON、または BYTES から選択します。Parquet 出力フォーマットは、専用クラスター および スタンダードクラスター でのみ使用できます。スキーマベースのメッセージフォーマット(Avro など)を使用するには、有効なスキーマが Schema Registry に存在する必要があります。

注釈

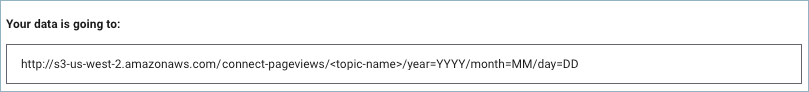

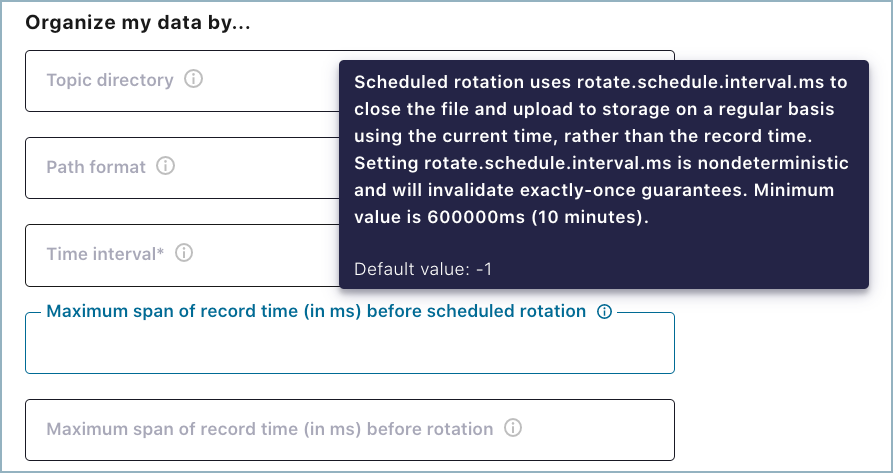

以下の Topic directory、Path format、 Time interval の各プロパティを使用して、S3 に格納するデータのディレクトリ構造するのに使用できます。例: Time interval を

Hourly、Topics directory をjson_logs/hourly、Path format を'dt'=YYYY-MM-dd/'hr'=HHに設定します。この場合、S3 のディレクトリ構造は、s3://<s3-bucket-name>/json_logs/daily/<Topic-Name>/dt=2020-02-06/hr=09/<files>になります。Time interval で、メッセージを S3 バケットに分ける方法を設定する時間間隔を選択します。たとえば、Hourly を選択すると、1 時間ごとに、メッセージがフォルダーに分けられてデータがバケットにストリーミングされます。

Flush size に入力します。デフォルトは 1000 です。この値は、必要に応じて増やすことができます。Confluent Cloud 専用クラスター を実行する場合は、この値を下げることができます(最小値 1)。専用ではないクラスターの最小値は 1000 です。熟練したユーザーは、以下をクリックして、コネクターがレコードを S3 にフラッシュする方法を定義できます。

Show advanced configurations

Topic directory: これは、S3 に格納するデータに使用する最上位ディレクトリのパスです。使用しない場合は、

topicsにデフォルト設定されます。Path format: これによって、S3 に作成される時間ベースのパーティショニングのパスを構成できます。このプロパティでは、UNIX のタイムスタンプが日付フォーマットの文字列に変換されます。このプロパティを使用しない場合は、

'year'=YYYY/'month'=MM/'day'=dd/'hour'=HH(Time interval に Hourly を選択した場合)または'year'=YYYY/'month'=MM/'day'=dd(Time interval に Daily を選択した場合)がデフォルトとして使用されます。ローテーション間隔。スケジュールによるローテーション の 2 つのプロパティの詳細については、「スケジュールによるローテーション」を参照してください。

どのような状況でレコードがストレージにフラッシュされるかを説明するために、以下に例を示します。

デフォルト設定の 1000 を使用し、トピックには 6 つのパーティションがあります。1000 件を超えるレコードが各パーティションに存在すると、ストレージでのファイルの作成が開始されます。

デフォルト設定の 1000 を使用し、パーティショナーが "Hourly" に設定されています。午後 2 時から午後 3 時までの間に 1 つのパーティションに 500 件のレコードが到達しました。午後 3 時にさらに 5 件のレコードがそのパーティションに到達しました。午後 3 時にストレージには、500 件のレコードが表示されます。

注釈

rotate.schedule.interval.msプロパティとrotate.interval.msプロパティをflush.sizeと一緒に使用して、ストレージにファイルを作成する条件を指定できます。これらのパラメーターが有効になり、最初に満たされた条件に基づいてファイルが保管されます。たとえば、トピックのパーティションが 1 つあるとします。

flush.size=1000とrotate.schedule.interval.ms=600000(10 分)を設定します。12:01 から 12:10 までのこのトピックパーティションに 500 件のレコードが表示されます。12:11 から 12:20 まで、追加の 500 件のレコードが表示されます。それぞれ 500 件のレコードが入った 2 つのファイルがストレージバケットに表示されます。これは、flush.size=1000条件が満たされる前に、10 分のrotate.schedule.interval.ms条件が作動したからです。

Timestamp field name: タイムスタンプとして使用するレコードフィールドです。これが時間ベースパーティショナーで使用されます。使用しない場合は、Kafka レコードを Kafka ブローカーが生成または格納したタイムスタンプがデフォルトとして使用されます。

Timezone: 有効なタイムゾーン を使用します。使用しない場合は、

UTCがデフォルト設定されます。Locale: 日付および時刻のフォーマット設定に使用されます。たとえば、英語(米国)の場合は

en-US、英語(英国)の場合はen-GB、英語(インド)の場合はen-IN、フランス語(フランス)の場合はfr-FRを使用できます。デフォルトはenです。ロケール ID のリストについては、『Java のロケール』を参照してください。How to handle records with null values: null 値を含むレコード(Kafka tombstone レコードなど)を処理する方法。デフォルトは

ignoreです。Compression Type: Gzip の場合、Gzip Compression Level (

1から9まで)を選択する必要があります。1を選択すると、高速圧縮ですが低い圧縮率になります。9を選択すると、圧縮率は高くなりますが、圧縮速度は大幅に遅くなります。注釈

Parquet を使用する場合の圧縮タイプとして、現在

PARQUET - none、PARQUET - gzip、およびPARQUET - snappyのみがサポートされています。Preserves Avro schema information: デフォルトでは true です。

trueに設定すると、Avro スキーマから Connect スキーマへの変換時に、Avro スキーマのパッケージ情報と Enum が維持されます。この情報は、Connect スキーマから Avro スキーマへの変換時に再度追加されます。Schema compatibility: コネクターがスキーマ変更を検出する場合に使用されるスキーマの互換性規則。

An S3 canned ACL header value: オブジェクトの書き込み時に使用する Amazon S3 の既定 ACL ヘッダー値。

Enable or disable writing record keys to storage: ストレージへのレコードキーの書き込みを有効または無効にします。デフォルトは

falseです。Value Converter Connect Metadata: メタデータを出力スキーマに追加する Connect コンバーターを有効または無効にします。デフォルトは

trueです。Enable or disable writing record headers to storage: ストレージへのレコードヘッダーの書き込みを有効または無効にします。デフォルトは

falseです。Tag S3 objects offsets and record count: S3 オブジェクトに開始および終了オフセットとレコード数のタグを付けます。

The S3 Server Side Encryption Algorithm: 使用する S3 サーバー側の暗号化 アルゴリズムのタイプ。

S3 Server Side (SSE-C) Key: お客様が用意したサーバー側の暗号化キー(SSE-C)。

Part Size in multipart uploads: S3 オブジェクトの マルチパートアップロード 用のパートのサイズ(バイト数)。デフォルトは

5242880です。Use S3 accelerated endpoint: S3 Transfer Acceleration を有効または無効にします。デフォルトは

falseです。Role ARN when starting a session: セッションを開始するときに使用する、ロールの ARN。

Role external ID under assumed role: 引き受けるロール のセッション認証情報を取得するときに使用する、ロールの外部 ID。

Role session name: セッションを開始するときに使用する、ロールのセッション名。

Continue をクリックします。

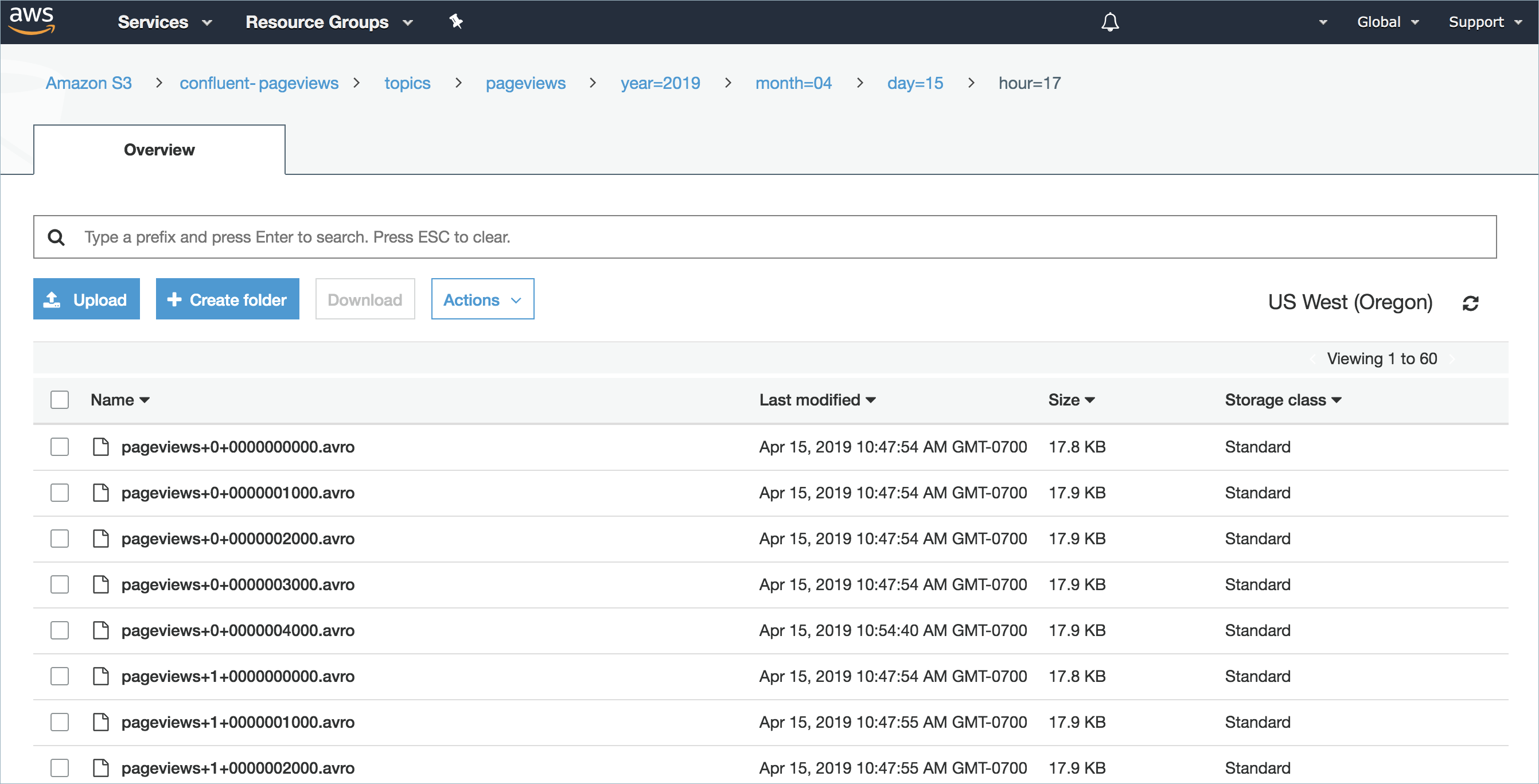

ステップ 5: S3 バケットを確認します。¶

AWS 管理コンソールに移動し、Storage、S3 の順に選択して、S3 バケットを確認します。

S3 バケットを開きます。

メッセージが表示されるまで、トピックのフォルダーと各下位フォルダーを開いていきます。

Connect 用の Confluent Cloud API の使用に関する詳細とサンプルについては、「Confluent Cloud API for Connect」セクションを参照してください。

ちなみに

コネクターを起動すると、デッドレターキューのトピックが自動的に生成されます。詳細については、「Confluent Cloud デッドレターキュー」を参照してください。

参考

フルマネージド型の Confluent Cloud コネクターが Confluent Cloud ksqlDB でどのように動作するかを示す例については、「Cloud ETL のデモ」を参照してください。この例では、Confluent CLI を使用して Confluent Cloud のリソースを管理する方法についても説明しています。

Confluent CLI の使用¶

以下の手順に従うと、Confluent CLI を使用してコネクターをセットアップし、実行できます。

注釈

- すべての 前提条件 を満たしていることを確認してください。

- コマンド例では Confluent CLI バージョン 2 を使用しています。詳細については、「Confluent CLI v2 への移行 <https://docs.confluent.io/confluent-cli/current/migrate.html#cli-migrate>`__」を参照してください。

ステップ 2: コネクターの必須の構成プロパティを表示します。¶

以下のコマンドを実行して、コネクターの必須プロパティを表示します。

confluent connect plugin describe <connector-catalog-name>

例:

confluent connect plugin describe S3_SINK

出力例:

Following are the required configs:

connector.class: S3_SINK

name

kafka.auth.mode

kafka.api.key

kafka.api.secret

aws.access.key.id

aws.secret.access.key

input.data.format

output.data.format

compression.codec

s3.compression.level

s3.bucket.name

time.interval

tasks.max

topics

ステップ 3: コネクターの構成ファイルを作成します。¶

コネクター構成プロパティを含む JSON ファイルを作成します。以下の例は、コネクターの必須プロパティを示しています。

{

"name" : "confluent-s3-sink",

"connector.class": "S3_SINK",

"kafka.auth.mode": "KAFKA_API_KEY",

"kafka.api.key": "<my-kafka-api-key>",

"kafka.api.secret": "<my-kafka-api-secret>",

"aws.access.key.id" : "<my-aws-access-key>",

"aws.secret.access.key": "<my-aws-access-key-secret>",

"input.data.format": "JSON",

"output.data.format": "JSON",

"compression.codec": "JSON - gzip",

"s3.compression.level": "6",

"s3.bucket.name": "<my-bucket-name>",

"time.interval" : "HOURLY",

"flush.size": "1000",

"tasks.max" : "1"

"topics": "<topic-1>, <topic-2>",

}

以下の必須プロパティの定義に注意してください。

"name": 新しいコネクターの名前を設定します。"connector.class": コネクターのプラグイン名を指定します。

"kafka.auth.mode": 使用するコネクターの認証モードを指定します。オプションはSERVICE_ACCOUNTまたはKAFKA_API_KEY(デフォルト)です。API キーとシークレットを使用するには、構成プロパティkafka.api.keyとkafka.api.secretを構成例(前述)のように指定します。サービスアカウント を使用するには、プロパティkafka.service.account.id=<service-account-resource-ID>に リソース ID を指定します。使用できるサービスアカウントのリソース ID のリストを表示するには、次のコマンドを使用します。confluent iam service-account list

例:

confluent iam service-account list Id | Resource ID | Name | Description +---------+-------------+-------------------+------------------- 123456 | sa-l1r23m | sa-1 | Service account 1 789101 | sa-l4d56p | sa-2 | Service account 2

"input.data.format": Kafka 入力レコード値のフォーマット(Kafka トピックから送られるデータ)を設定します。指定可能なエントリは、AVRO、JSON_SR、PROTOBUF、JSON、または BYTES です。スキーマベースのメッセージフォーマット(たとえば、Avro、JSON_SR(JSON スキーマ)、および Protobuf)を使用するには、Confluent Cloud Schema Registry を構成しておく必要があります。注釈

このコネクターでは、以下の入出力フォーマットはサポートされていません。

- 入力フォーマット JSON から出力フォーマット AVRO

- 入力フォーマット JSON から出力フォーマット PARQUET

"output.data.format": Kafka 出力レコード値のフォーマット(コネクターから送られるデータ)を設定します。指定可能なエントリは、AVRO、PARQUET、JSON、または BYTES です。Parquet 出力フォーマットは、専用クラスター および スタンダードクラスター でのみ使用できます。スキーマベースのメッセージフォーマット(Avro など)を使用するには、有効なスキーマが Schema Registry に存在する必要があります。"compression.codec": 圧縮タイプを設定します。入力できる値は、AVRO - bzip2、AVRO - deflate、AVRO - snappy、BYTES - gzip、またはJSON - gzipです。PARQUET の場合の圧縮タイプとしては、現在PARQUET - none、PARQUET - gzip、およびPARQUET - snappyのみがサポートされています。"s3.compression.level": gzip レベルを設定します。入力できる値は、1から9までです。1を選択すると、高速圧縮ですが低い圧縮率になります。9を選択すると、圧縮率は高くなりますが、圧縮速度は大幅に遅くなります。デフォルトの gzip 圧縮レベルは6です。"time.interval": メッセージを S3 バケットに分ける方法を設定します。入力できる値は、DAILY または HOURLY です。(省略可)``flush.size``: デフォルト値は 1000 です。この値は、必要に応じて増やすことができます。Confluent Cloud 専用クラスター を実行する場合は、この値を下げることができます(最小値 1)。専用ではないクラスターの最小値は 1000 です。

どのような状況でレコードがストレージにフラッシュされるかを説明するために、以下に例を示します。

デフォルト設定の 1000 を使用し、トピックには 6 つのパーティションがあります。1000 件を超えるレコードが各パーティションに存在すると、ストレージでのファイルの作成が開始されます。

デフォルト設定の 1000 を使用し、パーティショナーが "Hourly" に設定されています。午後 2 時から午後 3 時までの間に 1 つのパーティションに 500 件のレコードが到達しました。午後 3 時にさらに 5 件のレコードがそのパーティションに到達しました。午後 3 時にストレージには、500 件のレコードが表示されます。

注釈

rotate.schedule.interval.msプロパティとrotate.interval.msプロパティをflush.sizeと一緒に使用して、ストレージにファイルを作成する条件を指定できます。これらのパラメーターが有効になり、最初に満たされた条件に基づいてファイルが保管されます。たとえば、トピックのパーティションが 1 つあるとします。

flush.size=1000とrotate.schedule.interval.ms=600000(10 分)を設定します。12:01 から 12:10 までのこのトピックパーティションに 500 件のレコードが表示されます。12:11 から 12:20 まで、追加の 500 件のレコードが表示されます。それぞれ 500 件のレコードが入った 2 つのファイルがストレージバケットに表示されます。これは、flush.size=1000条件が満たされる前に、10 分のrotate.schedule.interval.ms条件が作動したからです。

"tasks.max": このコネクターで使用できる タスク の最大数を入力します。"topics": 特定のトピック名を指定するか、複数のトピック名をコンマ区切りにしたリストを指定します。ちなみに

上記の

time.intervalプロパティと、オプションのプロパティtopics.dirおよびpath.formatを使用して、S3 に格納するデータのディレクトリ構造を作成できます。例:"time.interval" : "HOURLY"、"topics.dir" : "json_logs/hourly"、"path.format" : "'dt'=YYYY-MM-dd/'hr'=HH"を設定します。この場合、S3 のディレクトリ構造は、s3://<s3-bucket-name>/json_logs/daily/<Topic-Name>/dt=2020-02-06/hr=09/<files>になります。

ストレージのデータを編成するために使用できるオプションのプロパティを以下に示します。

"topics.dir": これは、S3 に格納するデータに使用する最上位ディレクトリのパスです。使用しない場合は、topicsがデフォルトとして使用されます。""path.format": これによって、S3 に作成される時間ベースのパーティショニングのパスを構成できます。このプロパティでは、UNIX のタイムスタンプが日付フォーマットの文字列に変換されます。このプロパティを使用しない場合は、'year'=YYYY/'month'=MM/'day'=dd/'hour'=HH(time.intervalに Hourly を選択した場合)または'year'=YYYY/'month'=MM/'day'=dd(Daily の時間間隔を選択した場合)がデフォルトとして使用されます。rotate.schedule.interval.msおよびrotate.interval.ms: これらのプロパティの使用方法について詳しくは、「スケジュールによるローテーション」を参照してください。timestamp.field: タイムスタンプとして使用するレコードフィールドです。これが時間ベースパーティショナーで使用されます。使用しない場合は、Kafka レコードを Kafka ブローカーが生成または格納したタイムスタンプがデフォルトとして使用されます。"timezone": 有効なタイムゾーン。たとえば、EST、PST、WET、またはUTCなどを使用できます。使用しない場合は、UTCがデフォルト設定されます。"locale"。時間ベースのパーティショナーで使用するロケール。日付および時刻のフォーマット設定に使用されます。たとえば、英語(米国)の場合はen-US、英語(英国)の場合はen-GB、英語(インド)の場合はen-IN、フランス語(フランス)の場合はfr-FRを使用できます。デフォルトはenです。ロケール ID のリストについては、『Java のロケール』を参照してください。

プロパティの値と定義については、「構成プロパティ」を参照してください。

ステップ 4: プロパティファイルを読み込み、コネクターを作成します。¶

以下のコマンドを入力して、構成を読み込み、コネクターを起動します。

confluent connect create --config <file-name>.json

例:

confluent connect create --config s3-sink-config.json

出力例:

Created connector confluent-s3-sink lcc-ix4dl

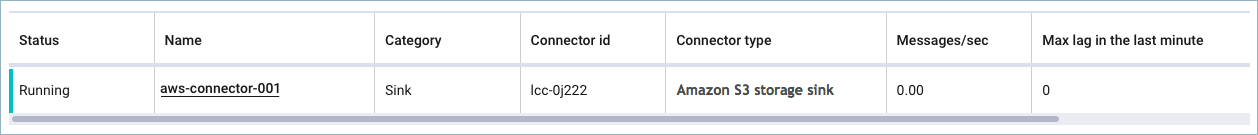

ステップ 5: コネクターのステータスを確認します。¶

以下のコマンドを入力して、コネクターのステータスを確認します。

confluent connect list

出力例:

ID | Name | Status | Type

+-----------+-------------------+---------+------+

lcc-ix4dl | confluent-s3-sink | RUNNING | sink

ステップ 6: S3 バケットを確認します。¶

Connect 用の Confluent Cloud API の使用に関する詳細とサンプルについては、「Confluent Cloud API for Connect」セクションを参照してください。

ちなみに

コネクターを起動すると、デッドレターキューのトピックが自動的に生成されます。詳細については、「Confluent Cloud デッドレターキュー」を参照してください。

スケジュールによるローテーション¶

ローテーションのスケジュールをセットアップできるように、2 つのオプションのプロパティが用意されています。これらのプロパティは、Cloud Console (以下の画面)と Confluent CLI にあります。

rotate.schedule.interval.ms(スケジュールによるローテーション): このプロパティを使用すると、ファイルを閉じてストレージにアップロードする定期的なスケジュールを構成できます。デフォルト値は-1(無効)です。たとえば、600000 ミリ秒に設定すると、少なくとも 10 分ごとにストレージバケットにファイルが生成されます。rotate.schedule.interval.msは、継続的なデータストリームを必要としません。注釈

rotate.schedule.interval.msプロパティを使用すると、非決定的な環境になるので、"厳密に 1 回" の保証は無効になります。rotate.interval.ms(ローテーションの間隔) : このプロパティを使用すると、追加レコードためにファイルを開いたままにできる最長期間(ミリ秒)を指定できます。このプロパティを使用する場合、ファイルのタイム時間間隔はファイルに追加された最初のレコードのタイムスタンプから開始します。最初のファイルのタイムスタンプから始まる期間に収まっていないタイムスタンプのレコードが到着したときに、コネクターはファイルをクローズしてストレージにアップロードします。最小値は 600000 ミリ秒(10 分)です。このプロパティのデフォルトは、time.intervalプロパティで設定された間隔です。rotate.interval.msは、継続的なデータストリームを必要とします。重要

期間の開始と終了は、ファイルのタイムスタンプによって決まります。そのため、最初のファイルのタイムスタンプから始まる期間に収まっていないタイムスタンプのレコードが到着するまで、ファイルが長時間開いたままになる可能性があります。

構成プロパティ¶

このコネクターでは、以下のコネクター構成プロパティを使用します。

データの取得元とするトピック(Which topics do you want to get data from?)¶

topics特定のトピック名を指定するか、複数のトピック名をコンマ区切りにしたリストを指定します。

- 型: list

- 重要度: 高

入力メッセージ(Input messages)¶

input.data.formatKafka 入力レコード値のフォーマットを設定します。指定可能なエントリは、AVRO、JSON_SR、PROTOBUF、JSON、または BYTES です。スキーマベースのメッセージフォーマット(AVRO、JSON_SR、PROTOBUF など)を使用する場合は、Confluent Cloud Schema Registry を構成しておく必要がある点に注意してください。

- 型: string

- 重要度: 高

データへの接続方法(How should we connect to your data?)¶

nameコネクターの名前を設定します。

- 型: string

- 指定可能な値: 最大 64 文字の文字列

- 重要度: 高

Kafka クラスターの認証情報(Kafka Cluster credentials)¶

kafka.auth.modeKafka の認証モード。KAFKA_API_KEY または SERVICE_ACCOUNT を指定できます。デフォルトは KAFKA_API_KEY モードです。

- 型: string

- デフォルト: KAFKA_API_KEY

- 指定可能な値: KAFKA_API_KEY、SERVICE_ACCOUNT

- 重要度: 高

kafka.api.key- 型: password

- 重要度: 高

kafka.service.account.idKafka クラスターとの通信用の API キーを生成するために使用されるサービスアカウント。

- 型: string

- 重要度: 高

kafka.api.secret- 型: password

- 重要度: 高

Amazon S3 の詳細(Amazon S3 details)¶

aws.access.key.id- 型: password

- 重要度: 高

aws.secret.access.key- 型: password

- 重要度: 高

s3.bucket.nameAmazon S3 バケットが Confluent Cloud クラスターと同じリージョンに存在している必要があります。

- 型: string

- 重要度: 高

s3.ssea.nameS3 サーバー側の暗号化アルゴリズム(SSE)。

- 型: string

- デフォルト: ""

- 重要度: 低

s3.sse.customer.keyユーザーが用意した S3 サーバー側の暗号化キー(SSE-C)。

- 型: password

- デフォルト: [hidden]

- 重要度: 低

s3.part.sizeS3 マルチパートアップロードにおけるパートのサイズ(バイト数)。

- 型: int

- デフォルト: 5242880

- 指定可能な値: [5242880,...,2147483647]

- 重要度: 高

s3.wan.modeS3 の高速化エンドポイントを使用します。

- 型: boolean

- デフォルト: false

- 重要度: 中

sts.role.arnセッション開始時に使用するロールの ARN。

- 型: string

- 重要度: 高

sts.role.external.id引き受けるロールのセッション認証情報を取得するときに使用されるロールの外部 ID。

- 型: string

- 重要度: 中

sts.role.session.nameセッション開始時に使用するロールのセッション名。

- 型: string

- 重要度: 高

出力メッセージ(Output messages)¶

output.data.formatSet the output message format for values. Valid entries are AVRO, JSON, PARQUET or BYTES. Note that you need to have Confluent Cloud Schema Registry configured if using a schema-based message format like AVRO. Note that the output message format defaults to the value in the Input Message Format field. If either PROTOBUF or JSON_SR is selected as the input message format, you should select one explicitly. If no value for this property is provided, the value specified for the 'input.data.format' property is used.

- 型: string

- 重要度: 高

output.keys.formatSet the output format for keys. Valid entries are AVRO, JSON, PARQUET or BYTES. Note that you need to have Confluent Cloud Schema Registry configured if using a schema-based message format like AVRO.

- 型: string

- Default: AVRO

- Valid Values: AVRO, BYTES, JSON, PARQUET

- 重要度: 高

output.headers.formatSet the output format for headers. Valid entries are AVRO, JSON, PARQUET or BYTES. Note that you need to have Confluent Cloud Schema Registry configured if using a schema-based message format like AVRO.

- 型: string

- Default: AVRO

- Valid Values: AVRO, BYTES, JSON, PARQUET

- 重要度: 高

データ編成の基準(Organize my data by...)¶

topics.dirKafka から取り込んだデータを保管するディレクトリを構成します。s3://<s3-bucket-name>/json_logs/daily/<Topic-Name>/dt=2020-02-06/hr=09/<files> のようにファイルを編成するには、topic.directory=json_logs/daily、path.format='dt'=YYYY-MM-dd/'hr'=HH、time.interval=HOURLY を使用してください。

- 型: string

- デフォルト: topics

- 重要度: 高

path.formatTimeBasedPartitioner を使用してパーティション分割を行う場合に、この構成を使用して、データディレクトリのフォーマットを設定します。この構成で設定したフォーマットに従って、UNIX のタイムスタンプが有効なディレクトリ文字列に変換されます。s3://<s3-bucket-name>/json_logs/daily/<Topic-Name>/dt=2020-02-06/hr=09/<files> のようにファイルを編成するには、topic.directory=json_logs/daily、path.format='dt'=YYYY-MM-dd/'hr'=HH、および time.interval=HOURLY プロパティを使用します。

- 型: string

- デフォルト: 'year'=YYYY/'month'=MM/'day'=dd/'hour'=HH

- 重要度: 高

time.intervalストレージに取り込まれた時間に応じた、データのパーティショニング間隔。

- 型: string

- 重要度: 高

rotate.schedule.interval.msスケジュールによるローテーションでは、rotate.schedule.interval.ms を使用して定期的にファイルを閉じ、ストレージにアップロードします。その際、レコードの時刻ではなく、現在時刻が使用されます。rotate.schedule.interval.ms の設定は非決定的であり、"厳密に 1 回" の保証は無効になります。最小値は 600000 ミリ秒(10 分)です。

- 型: int

- デフォルト: -1

- 重要度: 中

rotate.interval.msコネクターのローテーションの間隔では、ファイルを開いてレコードを書き込みできる状態にしておく期間の最大値(ミリ秒)を指定します。つまり、rotate.interval.ms を使用する場合、各ファイルのタイムスタンプはファイルに挿入された最初のレコードのタイムスタンプから開始します。次のレコードのタイムスタンプが最初のレコードのタイムスタンプのファイルの rotate.interval の期間に収まらない場合、コネクターはファイルを閉じて Blob Storage にアップロードします。コネクターで処理するレコードがそれ以上ない場合、次のレコードを処理できるようになるまでの間、コネクターはファイルを開いたままにすることがあります(長時間になる可能性があります)。最小値は 600000 ミリ秒(10 分)です。このプロパティの値が指定されていない場合、'time.interval' プロパティに指定されている値が使用されます。

- 型: int

- 重要度: 高

flush.sizeファイルのコミットを呼び出す前にストレージに書き込まれるレコードの数。

- 型: int

- デフォルト: 1000

- 重要度: 高

timestamp.fieldTimeBasedPartitioner に使用されるタイムスタンプを含むフィールドを設定します

- 型: string

- デフォルト: ""

- 重要度: 高

compression.codecS3 に書き込むファイルの圧縮タイプ。

- 型: string

- Valid Values: AVRO - bzip2, AVRO - deflate, AVRO - snappy, BYTES - gzip, JSON - gzip, PARQUET - gzip, PARQUET - none, PARQUET - snappy

- 重要度: 高

timezoneTimeBasedPartitioner で使用されるタイムゾーンを設定します。

- 型: string

- デフォルト: UTC

- 重要度: 高

behavior.on.null.valuesnull 値を含むレコード(Kafka tombstone レコードなど)を処理する方法。指定可能なオプションは、「ignore」および「fail」です。デフォルトは「ignore」です

- 型: string

- デフォルト: ignore

- 重要度: 低

s3.compression.levelS3 に書き込むファイルで使用する Gzip 圧縮レベル。JSON 入力または BYTES 入力を使用する場合に適用されます。

- 型: int

- 指定可能な値: [-1,...,9]

- 重要度: 高

localeTimeBasedPartitioner で使用するロケールを設定します。

- 型: string

- デフォルト: en

- 重要度: 高

enhanced.avro.schema.supporttrue に設定すると、Avro スキーマから Connect スキーマへの変換時に、Avro スキーマのパッケージ情報と Enum が維持されます。この情報は、Connect スキーマから Avro スキーマへの変換時に再度追加されます。

- 型: boolean

- デフォルト: true

- 重要度: 低

s3.acl.cannedオブジェクトの書き込み時に適用する S3 の既定 ACL ヘッダー値。

- 型: string

- 指定可能な値: authenticated-read、aws-exec-read、bucket-owner-full-control、bucket-owner-read、log-delivery-write、private、public-read、public-read-write

- 重要度: 低

schema.compatibilityコネクターによってスキーマ変更が検出された場合に使用されるスキーマの互換性規則。

- 型: string

- デフォルト: NONE

- 重要度: 高

value.converter.connect.meta.dataConnect コンバーターの有効化と無効化を切り替えて、メタデータを出力スキーマに追加するかどうかを指定します。

- 型: boolean

- デフォルト: true

- 重要度: 中

store.kafka.keysストレージへのレコードキーの書き込みを有効または無効にします。

- 型: boolean

- デフォルト: false

- 重要度: 低

store.kafka.headersストレージへのレコードヘッダーの書き込みを有効または無効にします。

- 型: boolean

- デフォルト: false

- 重要度: 低

s3.object.taggingS3 オブジェクトに開始および終了オフセットとレコード数のタグを付けます。

- 型: boolean

- デフォルト: false

- 重要度: 低

このコネクターのタスク数(Number of tasks for this connector)¶

tasks.max- 型: int

- 指定可能な値: [1、…]

- 重要度: 高

次のステップ¶

参考

フルマネージド型の Confluent Cloud コネクターが Confluent Cloud ksqlDB でどのように動作するかを示す例については、「Cloud ETL のデモ」を参照してください。この例では、Confluent CLI を使用して Confluent Cloud のリソースを管理する方法についても説明しています。